سایت Towards Data Science با نظریه پرداز هوش مصنوعی بر روی تحقیقات مهم او در Google Brain ، چگونگی کار یادگیری تقویتی عمیق و موارد دیگر مصاحبه کرده است.

مصاحبه کننده: هابیچان یونگ (Haebichan Jung)، رهبر پروژه در TowardsDataScience.com.

مصاحبه شونده: آزالیا میرحسینی (Azalia Mirhoseini)، دکترا ، رهبر فنی و دانشمند ارشد تحقیقات در “Google Brain”. یکی از “۳۵ نوآوران/ متفکرین زیر ۳۵ سال” توسط نشریه MIT.

این مصاحبه در اجلاس یادگیری ماشین تورنتو (TMLS) در نوامبر ۲۰۱۹ انجام شد.

آیا می توانید از پیشینه حرفه ای خود برای ما بگویید؟

من کارشناسی ارشد و دکترای خود را در رشته مهندسی برق و کامپیوتر در دانشگاه رایس گرفتم. من برای طراحی الگوریتم و کد سخت افزار / نرم افزار برای مدل تجزیه و تحلیل دادهها در مقیاس بزرگ و یادگیری ماشین کار میکردم. هنگام پایان دوره دکترای من وقتی ” یادگیری عمیق ( Deep Learning ) ” کلید خورد، تمرکز خود را به یادگیری عمیق تغییر دادم.

پس از آن، یک بروشور آگهی برای برنامه اقامت “Google Brain” دیدم. هدف آن بود که افراد با پیشینه هایی غیر از ” یادگیری عمیق یا ماشین ( Deep/Machine Learning ) ” در این زمینه محقق شوند. من الان ۳٫۵ سال است که در آنجا هستم.

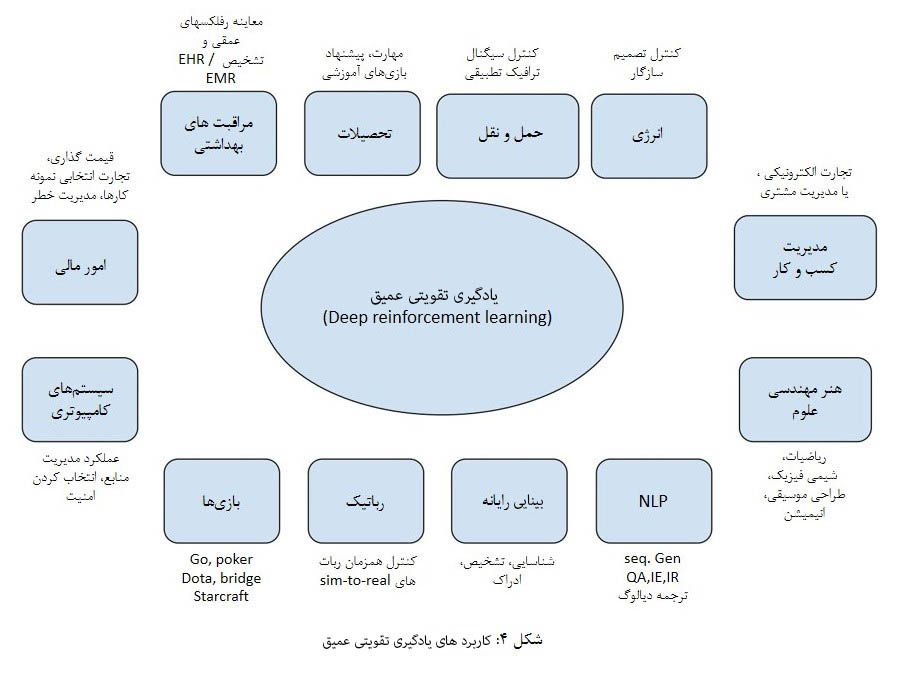

با توجه به ملاحظات جزئی ، موردی که من در جامعه ” یادگیری ماشین ( Machine Learning ) ” متوجه شدم که بسیار رایج است، این است که بسیاری از افراد برای تحقیق در زمینه های بینایی رایانهای ، NLP ، رباتیک ، یادگیری ماشین و بازیها بسیار هیجان زده هستند.

بنابراین من به استفاده از انجام یادگیری ماشین برای طراحی سیستمها و رایانه بسیار هیجان زده شدم زیرا این موارد بزرگترین توانمندسازی یادگیری ماشین هستند. موفقیت زیادی در یادگیری عمیق به دلیل سخت افزار و سیستمهای بهتری که اکنون داریم و ۱۰ سال پیش در اختیار نداشتیم، وجود دارد.

آیا می توانید چند مثال از نقش سیستم ها یا تراشه ها در پیشرفت هوش مصنوعی برای ما بزنید؟

البته، به عنوان مثال، تنسورفلو ( Tensorflow کتابخانه متن باز برای زبان پایتون ) و پایتورچ ( Pytorch کتابخانه متن باز برای زبان پایتون بر اساس تورچ ) که بسیار قدرتمند اند، و افراد می توانند به راحتی برای آموزش مدل های یادگیری عمیق خود از آن ها استفاده کنند. مدل های مهم دیگر این تراشه ها و سخت افزارها مانند GPUها و TPU ها هستند.

TPU یا واحد پردازش تنسور (Tensor) از جمله سخت افزارهای بسیار قدرتمندی برای اجرای الگوریتم های یادگیری ماشین هستند که قبلاً نداشتیم. این نوع سیستمها یادگیری عمیق را به صورت آنچه که امروز هست، توانمند می سازند.

علاوه بر این، اگر به روند پیشرفت هوش مصنوعی توجه کنید، متوجه می شویم که ما واقعاً به سخت افزار های رایانه ای که به میزان قابل توجهی بهتر هستند نیاز داریم تا بتوانیم به خواستههای محاسباتی هوش مصنوعی رسیدگی کنیم. بنابراین راهی که من در مورد آن فکر می کنم استفاده از ماشین یادگیری برای کمک به هوش مصنوعی و طراحی نسل بعدی سیستم ها و تراشه ها است.

آیا توسعه این سیستم ها مسئولیت اصلی شما در “Google Brain” است؟

در سال ۲۰۱۸، من و همکارم آنا گلدی تیم یادگیری ماشین برای سیستم ها را در “Google Brain” تأسیس کردیم. تمرکز اصلی تیم ما استفاده از هوش مصنوعی برای طراحی و بهینه سازی نسل بعدی سیستم ها و تراشه ها است. نوع تحقیقاتی که ما بر روی آن تمرکز می کنیم اکثراً الگوریتم های تقویتی عمیق است – روش های بهینه سازی تصمیم گیری متوالی که به ما این امکان را می دهد تا مشکلات بهینه سازی در مقیاس بزرگ را حل کنیم.

منظور شما از فرآیند تصمیم گیری متوالی چیست؟

برای مثال، در یک کار رباتیک، بگذارید بگوییم یک ربات می خواهد به یک هدفی برسد. این ربات در یک شبکه ۲ بعدی قرار دارد و می خواهد به اطراف حرکت کند. تصمیم گیری متوالی تصمیماتی در مورد حرکت اول ربات ها (چپ ، راست ، مستقیم جلو ، موانع و غیره) است.

بنابراین مجموعه تصمیماتی وجود دارد که شما به ترتیب دنبال می کنید. شما یک عمل را انجام می دهید، که به راست بروید. و بعد اقدام بعدی را انجام می دهید. اقدامات شما به اقدامات انجام شده قبلی شما مشروط است.

هدف نهایی شما این است که مجموعه اقدامات را انجام دهید تا در سریعترین زمان ممکن با حداقل تعداد حرکات به هدف برسید. وظیفه تصمیم گیری متوالی مربوط به این است که چگونه می توانید یک سری از تصمیمات را به گونه ای انجام دهید که به روشی بهینه سازی شده به تابع پاداش هدف خود برسید (هر آنچه که باشد).

چگونه بهینه سازی در آن فرآیند اتفاق می افتد؟

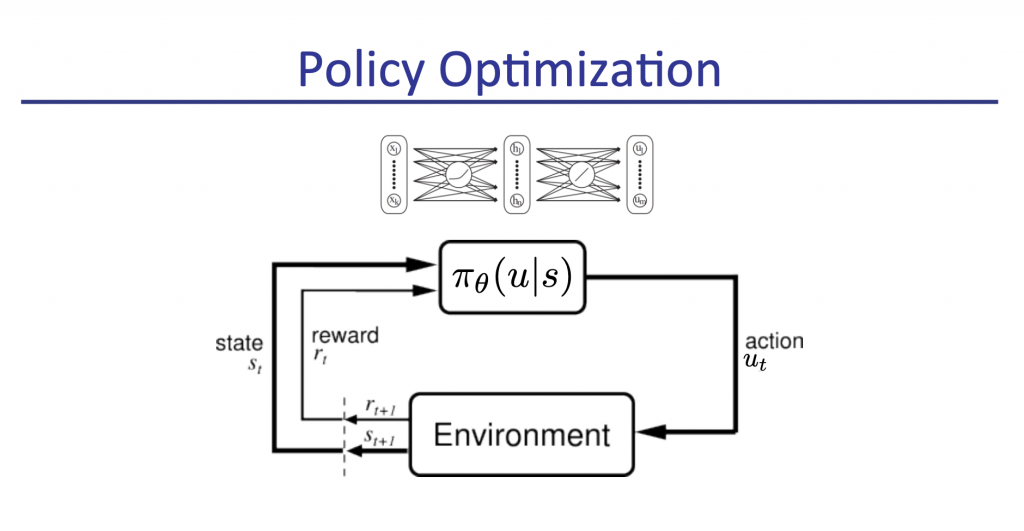

من در مورد بهینه سازی خط مشی ( یادگیری تقویتی ) به شما خواهم گفت. شما می توانید تصور کنید که شما یک مدل شبکه عصبی دارید که نمایانگر خط مشی شما است. در آغاز:

- این مدل با وزن های تصادفی آغاز می شود. در مورد محیط شما چیزی نمی داند. اما به تدریج یاد می گیرد.

- مدل وضعیت فعلی مشکل شما را می گیرد و توزیع احتمالی را نسبت به عملکردهایی که انجام می دهید، بیان می کند. بگذارید بگوییم که شما ۴ عمل (بالا ، پایین ، چپ ، راست) دارید. شما این اقدامات را انجام می دهید و عملکرد خود را مانند تابع پاداش، که چقدر به هدف خود چقدر نزدیک هستید را اندازه میگیرید.

- شما اکنون این تابع پاداش واسطه را دارید و تا رسیدن به هدف خود، اقدامات بعدی را انجام میدهید.

- از تابع پاداش نهایی از مجموعه توابع پاداش واسطه می تواند برای بازگرداندن و به روزرسانی پارامترهای شبکه عصبی که نمایانگر خط مشی شما است، استفاده شود.

منظور از اصطلاح خط مشی در اینجا چیست؟

خط مشی در اینجا به معنای مدل یادگیری تقویتی است. دلیل اینکه چرا “خط مشی” نامگذاری شده این است که حالت ورودی را می گیرد و مجموعه ای از اقدامات را انجام می دهد. این مدل با توجه به یک وضعیت داده شده یک اقدام را پیشبینی میکند. به همین دلیل این مدل خط مشی خوانده می شود.

آیا می توانید روشن کنید که چگونه بهینه سازی بدون یک متغیر هدف و فقط تنها بر اساس توابع پاداش اتفاق می افتد؟

بله، در اینجا هیچ برچسبی وجود ندارد، اما ما هنوز وضعیت ورودی مسئله را داریم و در آخر میخواهیم تابع پاداش را بهینه کنیم. در بسیاری از این الگوریتم های بهینه سازی خط مشی، آنچه ما انجام می دهیم این است که، ما خط مشی را آموزش میدهیم که تابع پاداش مورد انتظار را با توجه به توزیع عملکردهای معین که مدل برای یک حالت داده شده پیش بینی میکند، بهینه کند.

بحث رو عوض کنیم، آیا می توانید درباره سایر تحقیقات هیجان انگیز یادگیری عمیق خود به ما بگویید: لایه های گسسته ی پراکنده تجمیع خبرگان ( Sparsely-Gated Mixture-of-Experts Layer )؟

این یکی از اولین پروژههای من بود که با گروهی عالی از همکاران وقتی به Google Brain پیوستم، انجام دادم. ایده پشت این لایه این است که اگر به مدل های یادگیری عمیق (تغییر دهنده ، کانوُلوشن، LSTM ها) بنگرید، تعداد زیادی از این ها نسبتاً متراکم هستند.

متراکم به این معنی است که مثالهای ورودی از ابتدا تا انتها در کل شبکه عبور میکنند. ما هر ورودی را با همان مقدار محاسبات در تمام مثالهای ورودی پردازش میکنیم.

ایده پشت این کار این است که ما می توانیم اتحادیه ای از خبرگان ( Experts ) داشته باشیم که در آن هر خبره توسط خود شبکه عصبی معرفی شود و این خبرگان می توانند در انواع مختلف داده ها در مجموعه داده های آموزش شما تخصص داشته باشند. بنابراین همانطور که می خواهید یک نمونه را در سراسر مدل انتشار دهید، نمونه از طریق این شبکه عصبی از مسیرهای مشخصی عبور می کند و تا انتها ادامه می یابد، اما نه از طریق همه مسیر ها.

مزایای بسیاری برای این مدل وجود دارد. اول ، ما می توانیم مدلهایی با ظرفیت زیادی داشته باشیم که بتوانند از دادههای عظیم یاد بگیرند. این بدان معنی است که ما می توانیم پارامترهای زیادی داشته باشیم. یکی از مدل هایی که ما ساخته بودیم دارای میلیاردها پارامتر بود که در آن میلیارد ها نقطه داده را روی آن آموزش دادیم.

زیبایی این مدل در سادگی آن است، به عنوان یک نمونه تنها بخش کوچکی از مدل را مشاهده میکند. ما میتوانیم بگوییم که ۱۰۲۴ خبره در کل شبکه وجود دارد، اما نمونه فقط از ۴ یا ۸ تا از خبرگان عبور میکند. بنابراین ما در این مدل ظرفیت بزرگی داریم اما میزان توان محاسباتی که برای هر نمونه اعمال می شود، هنوز بسیار اندک است. با این حال، این مدل بزرگ می تواند به صورت جمعی از مقدار زیادی از داده های ما با مقدار زیادی پارامتر، که می تواند برای رمزگذاری دانش و برای آموزش مدل استفاده کند، یاد بگیرد.

پس برای تکرار، لایه های گسسته ی پراکنده تجمیع خبرگان عبارت است از:

لایهای که با یک مدل کلی یکپارچه شده است و شما یک دسته از خبرگان (همان شبکههای عصبی) دارید که بخشهای مختلف داده ها را بررسی میکنند. اما چرا به مدل شما گسسته ی پراکنده ( Sparsely-Gated ) گفته میشود. آیا برای این است که ما به جز تعداد اندکی، به دنبال همه خبرگان نیستیم، اما شما هنوز قادر هستید که همانند همه خبرگان مختلف به نتایج مشابه برسید؟

و یا با نتایج بهتر! دلیل نامگذاری آن به Sparsely-Gated به این دلیل است که ما آنچه را که Gater (گسترنده) مینامیم را همراه با این خبرگان آموزش می دهیم. ورودی لایه خبره ابتدا به Gater میرود و Gater تصمیم می گیرد که کدام خبرگان باید این ورودی را پردازش کنند. تعداد کمی از این خبرگان هرگونه ورودی را از این Gater دریافت میکنند. Gater را به عنوان نمونههای مسیریابی ورودی تعداد کمی از خبرگان در نظر بگیرید. به همین دلیل به آن Sparse Gater گفته میشود.

و بله، همانطور که می گویید، ما این لایه های خبره را با Gater داریم و شما می توانید مانند LSTM آن را در یک مدل یادگیری عمیق تعبیه کنید. در کمال تعجب، نه تنها ما می توانیم نتیجه را سریع تر داشته باشیم یا به همان دقت دست یابیم، بلکه می توانیم به نتایج بهتری نیز دست پیدا کنیم. بخشی از این امر به این دلیل بود که ما می توانستیم داده های بیشتری را پردازش کنیم و بخش دیگر آن به دلیل اثرات منظم سازی لایه های گسسته ی پراکنده تجمیع خبرگان بود که باعث می شود مدل دادههای تست مشاهده نشده را بهتر تعمیم دهد.

آیا می توان در مورد منظم سازی با جزئیات توضیح داد؟

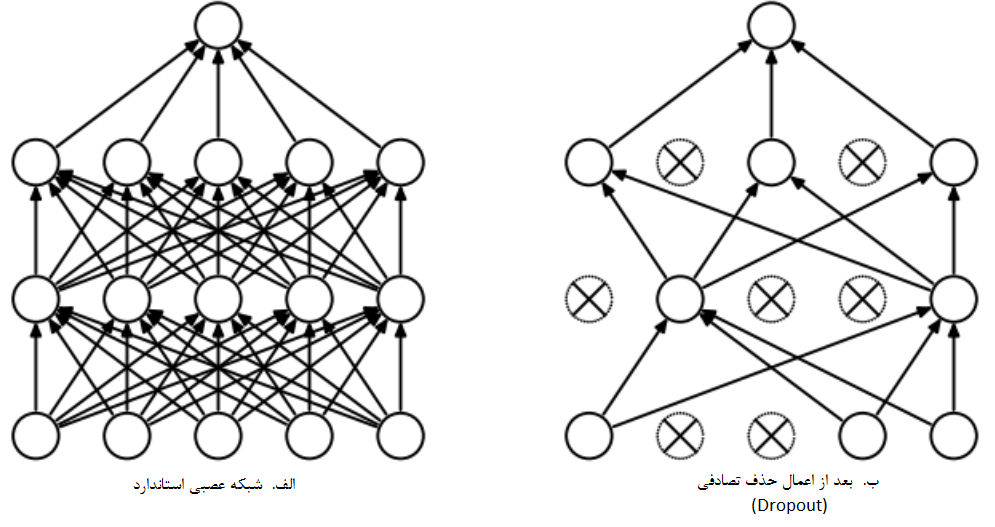

Dropout نمونهای از انجام منظم سازی است. شما می توانید در مورد تجمیع خبرگان ( MoE ) به عنوان تعبیری شبیه به حذف تصادفی فکر کنید. به جز آن که به شکل ساختار یافته تری مورد استفاده قرار میگیرد که در آن از مزایای کمبود برای بهره وری محاسباتی نیز استفاده می کنیم.

بنابراین ما همه این مدلها را داریم، و هربار که Gater به عنوان مثال به هر فعال ساز مورد نظر خود نگاه میکند، و آن را به تعداد کمی مدل منتقل میکند. در حالی که در یک لایه متراکم مشاهده می کنید که تمام مدل از آن عبور می کنند. در اینجا، ما در حال کاهش طراحی تعداد زیادی از خبرگان هستیم.

نکته جالب در مورد این تحقیق این است که شما مشکلی را حل کردید که محاسبات مشروط ( Conditional Computation ) سعی در حل آن داشت اما نتوانستند. میتوانید در این مورد بیشتر به ما بگویید؟

برای توضیح، دلیل اینکه چرا این یک محاسبات مشروط است این است که علی رغم اکثر مدلهای یادگیری عمیق که ورودی از طریق تمام شبکه عبور میکند، در اینجا ما یک ورودی را از طریق یک مدل Gater به طور مشترک با بقیه شبکه شرط میدهیم.

ما آن را از طریق Gater مشروط می کنیم تا آن را در مسیرهای خاصی از شبکه عصبی محدود کند. به این ترتیب، خبرگان یا ماژولهای ما در بخش های مختلف آموزش داده ها تخصص مییابند که به آن ها کمک می کند تا در پردازش و ارزیابی دادهها بهتر شوند.

آیا می توانید درباره Google Brain بیشتر به ما بگویید؟ تیمها چگونه ساختار یافتهاند و افراد چه نوع کاری انجام میدهند؟

Google Brain تیم عالی است که ما با تعداد زیادی از محققان و مهندسان عالی همکاری داریم که بسیار خوب با هم کار میکنند. ما روی مشکلات مهم و واقعاً سخت تمرکز می کنیم. کار با این تیم و کار کردن بر روی نوعی از مسائلی که ما انجام میدهیم بسیار سرگرم کننده است.

من میتوانم بگویم فرهنگ دانشگاهی خوبی داریم. ما در انتشارات و کنفرانس های سطح بالا، حضور فعالی داریم. ما واقعاً محققان خود را به انتشار و همکاری تشویق میکنیم.

در همین زمان، کارهای جالب بسیاری از Google Brain بیرون آمد. نمونه ای از آن Google Translate است که مبتنی بر رویکرد LSTM / Seq-2-Seq است که واقعاً شگفت انگیز است. آن ها تقریباً انقلابی در شیوه ترجمه ماشین NLP ایجاد کردند.

آیا با جفری هینتون ( Geoffrey Hinton ) کار می کنید؟

در واقع مقاله من در مورد لایه تجمیع خبرگان با جفری هینتون بود. من خیلی خوش شانس هستم که توانستم با او همکاری کنم. او یک شخص شگفت انگیز است، در کنار او بودن واقعا مایهی افتخار است. ایشان همچنین از فروتنترین افراد هستند.

سوال نهایی مخاطبان TDS: آینده هوش مصنوعی چیست؟ هوش مصنوعی به عنوان یک ابزار یا هوش مصنوعی به عنوان یک محصول؟ سناریوی محتملتر در آینده چیست؟

من درباره هوش مصنوعی بسیار خوش بین هستم. من معتقدم که هوش مصنوعی به همه کمک خواهد کرد. مطمئناً در صنعت آن ها میتوانند به محاسبات و دادههایی که برای دیگران ممکن نیست، دسترسی داشته باشند. در عین حال، احساس می کنم کار و تحقیقات زیادی وجود دارد که حتی بدون داده های زیادی نیز می توان انجام داد، زیرا در این صورت می توانید در مورد محدودیتهایی که داریم نوآوری کنید. ما این موارد را همیشه در دانشگاه میبینیم.

بنابراین فکر می کنم در دانشگاه و صنعت فرصتهایی برای شکوفایی وجود دارد و در این دوره هوش مصنوعی و در عین حال اگر کاری عالی انجام دهیم، به عنوان مثال خودرو های خودران، من شخصاً معتقدم این اتفاق برای همه عالی خواهد بود و وقت بیشتری را برای دنبال کردن چیزهای دیگر و نوآوری در زمینه های مختلف آزاد میکند.

بیشتر بخوانید :

- هوش مصنوعی مولد تهدیدات جدیدی برای امنیت سایبری ایجاد می کند

- فناوری تشخیص پلاک خودرو چگونه جامعه را هوشمندتر می کند

- گوگل ساختار سازمانی خود را جهت تمرکز بر هوش مصنوعی اصلاح می کند

- پلاک خوان های شهر گرینزبوروی آمریکا فعلاً قرار نیست افزایش پیدا کنند

- فرماندار اوکلند از پلاک خوان ها حمایت می کند اما مخالفان در اثربخشی آن تردید دارند

مجله هوش مصنوعی شهاب

مجله هوش مصنوعی شهاب