کاهش ابعاد – مقدمه

در این آموزش یادگیری ماشین ، ما به بررسی کاهش ابعاد می پردازیم. همچنین، به تمامی جنبه های مرتبط با یادگیری ماشین کاهش ابعاد مانند مراحل و روش های کاهش ابعاد ، تحلیل مولفه اصلی و اهمیت کاهش ابعاد ، انتخاب ویژگی ها ، مزایا و معایب کاهش ابعاد می پردازیم.

خب بیایید آموزش کاهش ابعاد را شروع کنیم.

کاهش ابعاد چیست؟

در یادگیری ماشین، ما فاکتورهای زیادی داریم که کلاسه بندی نهایی بر اساس آن ها انجام می شود. این عوامل اساساً به عنوان متغیر شناخته می شوند. هرچه تعداد ویژگی ها بیشتر باشد ، تجسم مجموعه آموزش و سپس کار بر روی آن دشوارتر می شود. بعضی اوقات ، بیشتر این ویژگی ها با هم مرتبط هستند و لذا ویژگی زائد تلقی می شوند. این جاست که الگوریتم های کاهش ابعاد بکار گرفته می شوند.

هدف

- وقتی با مسائل واقعی و داده های واقعی سروکار داریم ، اغلب با داده های با ابعاد بالا روبرو هستیم.

- داده ها ساختار اصلی خود را در ابعاد بالا ، نشان می دهند. اگرچه ، گاهی اوقات باید این ابعاد را کاهش داد.

- ما باید ابعاد را طوری کاهش دهیم که قابل تجسم باشند. گرچه همیشه اینطور نیست.

مولفه های کاهش ابعاد

دو عامل کاهش ابعاد عبارتند از :

الف- انتخاب ویژگی

در این بخش، ما باید زیرمجموعه ای از مجموعه اصلی متغیرها را پیدا کنیم. همچنین ، به زیرمجموعه ای نیاز داریم که برای مدلسازی مسئله از آن استفاده کنیم. این کار معمولاً شامل سه روش است :

- فیلتر ( Filter )

- بسته بندی کننده ( Wrapper )

- تجمیع شده ( Embedded )

ب- استخراج ویژگی

ما این فرآیند را برای کاهش ابعاد داده ها از یک فضای بُعد بالا به یک فضای بُعد پایین ، یعنی یک فضای با تعداد ابعاد کمتر اعمال می کنیم.

مطالعه جزئیات بیشتر درباره الگوریتم های یادگیری ماشین

روش های کاهش ابعاد

روش های مختلف مورد استفاده برای کاهش ابعاد عبارتند از:

- تحلیل مولفه های اصلی ( PCA )

- تحلیل تفکیک کننده خطی ( LDA )

- تحلیل تفکیک کننده تعمیم یافته ( GDA )

کاهش ابعاد، بسته به روش استفاده شده ممکن است هم خطی باشد و هم غیرخطی. روش خطی اصلی ، به نام تحلیل مولفه های اصلی یا PCA ، در ادامه بحث خواهد شد.

تحلیل مولفه اصلی

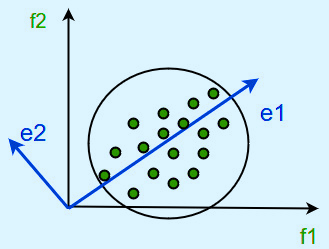

Karl Pearson این روش را معرفی کرده است. همچنین ، این روش تحت یک شرط کار می کند که می گوید داده ها در فضای با ابعاد بالا باید به داده ها در فضای ابعاد پایین تر نگاشت داده شوند. اگرچه ، واریانس داده ها در فضای با ابعاد کمتر، باید حداکثر باشد.

برای تصویر مراحل زیر را خواهیم داشت :

- ماتریس کوواریانس داده ها را بسازید.

- بردارهای ویژه این ماتریس را محاسبه کنید.

ما از بردارهای ویژه متناظر با بزرگترین مقادیر ویژه استفاده می کنیم. بدین معنی است که بخش عمده ای از واریانس داده های اصلی را بازسازی می کنیم.

از این رو ، تعداد کمتری بردار ویژه خواهیم داشت. و ممکن است در این روند برخی از داده ها را از دست بدهیم. اما ، مهم ترین واریانس ها باید توسط بردارهای ویژه باقی مانده حفظ شوند.

مطالعه بیشتر درباره کاربرد های یادگیری ماشین

اهمیت کاهش ابعاد

چرا کاهش ابعاد در مدلسازی پیش بینی یادگیری ماشین مهم است؟

مشکل افزایش ناخواسته ابعاد ، یک مشکل فراگیر است. این مشکل، ناشی از تثبیت اندازه گیری / ضبط داده هاست که از گذشته وجود داشته. این مسئله، مشکل جدیدی نیست، ولی اخیراً به دلیل افزایش داده ها ، اهمیت بیشتری پیدا کرده است.

اخیراً ، نحوه استفاده از سنسورها در صنعت ، افزایش چشمگیری پیدا کرده است. این سنسورها به طور مداوم داده ها را ضبط کرده و در مرحله بعد برای تجزیه و تحلیل ذخیره می کنند. با نحوه دریافت اطلاعات ، می توان افزونگی زیادی ایجاد کرد.

تکنیک های کاهش ابعاد چیست؟

اساساً ، کاهش ابعاد به فرآیند تبدیل مجموعه ای از داده ها اطلاق می شود. این داده ها باید دارای ابعاد گسترده ای در داده های با ابعاد کمتر باشند. همچنین ، باید اطمینان حاصل شود که اطلاعات مشابه را به طور خلاصه منتقل می کند. با اینکه ، ما از این روش ها برای حل مسائل یادگیری ماشین استفاده می کنیم ولی مشکل ، بدست آوردن ویژگی های بهتر برای یک طبقه بندی یا رگرسیون است.

روش های معمول برای انجام کاهش ابعاد

روش های زیادی برای انجام کاهش ابعاد وجود دارد که متداول ترین این روش ها را در ادامه خواهیم دید :

الف- مقادیر از دست رفته

هنگام جستجو در داده ها ، اگر با مقادیر از دست رفته مواجه شویم ، چکار کنیم؟ در اولین قدم باید دلیل آن را شناسایی کنیم. سپس باید مقادیر از دست رفته / متغیرهای حذف شده را با استفاده از روش های مناسب پیدا کرد. اما ، اگر مقدار از دست رفته زیادی داشته باشیم ، چه ؟ آیا باید مقادیر از دست رفته را پیدا کنیم یا متغیرها را حذف کنیم؟

ب- واریانس کم

بیایید به یک سناریو فکر کنیم که در مجموعه داده های مان، یک متغیر ثابت داریم ( همه مشاهدات دارای مقدار یکسان هستند ). فکر می کنید می تواند قدرت مدل را بهبود بخشد؟ البته که نه ، زیرا دارای واریانس صفر است.

ج- درختان تصمیم

این روش، یکی از تکنیک های پرطرفدار است. ما می توانیم از آن به عنوان یک راه حل نهایی برای مقابله با چالش های متعددی مانند از دست دادن مقادیر ، داده های پرت و شناسایی متغیرهای مهم استفاده کنیم. متخصصین داده زیادی از درخت تصمیم استفاده کردند و نتایج خوبی گرفتند.

د- جنگل تصادفی

جنگل تصادفی مشابه درخت تصمیم است. فقط مراقب باشید که جنگل های تصادفی تمایل به متغیرهایی دارند که مقادیر مجزای بیشتری داشته باشد، یعنی متغیرهای عددی را نسبت به مقادیر باینری / دسته ای ترجیح می دهیم.

ه- همبستگی زیاد

ابعادی که همبستگی بالاتری دارند می توانند عملکرد مدل را کاهش دهند. علاوه بر این ، داشتن چند متغیر از اطلاعات مشابه خوب نیست. برای شناسایی متغیرهای با همبستگی بالا ، می توانید از ماتریس همبستگی Pearson استفاده کنید. و یکی از آن متغیر ها را با استفاده از VIF ( عامل تورم واریانس ) انتخاب کنید. متغیرهایی که مقدار بالاتری دارند(VIF > 5) را می توان حذف کرد.

مطالعه درباره مزایا و معایب یادگیری ماشین

و- حذف ویژگی برگشتی

در این روش ، ما با تمام n بُعد شروع می کنیم. مجموع یک مربع خطا ( SSR ) را پس از حذف هر متغیر (n بار) محاسبه می کنیم. سپس ، متغیرهایی که حذف آنها کمترین افزایش را در SSR ایجاد کرده است، شناسایی می شوند. و درنهایت آن ها را حذف کرده و n-1 ویژگی ورودی را در اختیار ما قرار می دهد.

این روند تا زمانی که هیچ متغیر دیگری قابل حذف نباشد ، تکرار می شود.

ز- تحلیل عاملی

این متغیرها را می توان براساس همبستگی هایشان گروه بندی کرد. در اینجا هر گروه، یک ساختار یا عامل اساسی واحد را نشان می دهد. این عوامل در مقایسه با تعداد زیادی ابعاد ، تعداد کمی دارند. با این حال ، مشاهده این عوامل دشوار است. در واقع دو روش برای انجام تحلیل عاملی وجود دارد:

- EFA ( تحلیل عاملی اکتشافی )

- CFA ( تحلیل عاملی تأییدی )

ح- تحلیل مولفه های اصلی ( PCA )

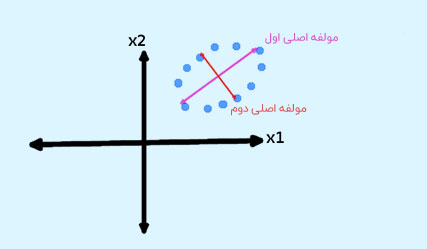

به طور خاص ، در این مورد باید متغیرها را به مجموعه متغیرهای جدید تبدیل کنیم. از آنجا که این متغیرها، ترکیبی خطی از متغیرهای اصلی هستند، لذا این مجموعه متغیرهای جدید ، مولفه های اصلی نامیده می شوند. بعلاوه ، ما باید این موارد را به روش خاصی بدست آوریم. به عنوان اولین مولفه اصلی ، تغییرات احتمالی داده های اصلی را حساب می کنیم. پس از آن هر مولفه برنده، بالاترین واریانس ممکن را دارد.

مولفه اصلی دوم باید عمود بر مولفه اصلی اول باشد. برای مجموعه داده های دو بعدی ، فقط دو مولفه اصلی وجود دارد. در شکل زیر، داده ها و اولین و دومین مولفه اصلی آن ها نشان داده شده است. با اعمال PCA بر روی مجموعه داده ها، داده ها معنای قبلی خود را از دست می دهند.

برای دریافت اطلاعات بیشتر در مورد PCA و نحوه پیاده سازی آن می توانید مقاله کاهش ابعاد با روش تحلیل مولفه های اصلی ( PCA ) را دنبال کنید.

کاهش تعداد ابعاد

- کاهش ابعاد از دیدگاه یادگیری ماشین، چندین مزیت دارد.

- از آنجا که مدل شما از درجه آزادی کمتری برخوردار است ، احتمال بیش برازش آن نیز کمتر است. مدل به سادگی به داده های جدید تعمیم می یابد.

- اگر ما از انتخاب ویژگی استفاده کنیم ، متغیرهای مهم را کمتر کاهش می دهد. همچنین ، به بهبود تفسیر پذیری مدل شما کمک می کند.

- اکثر تکنیک های استخراج ویژگی، بدون نظارت هستند، می توانید رمزگذار خودکار خود را آموزش دهید یا PCA خود را روی داده های بدون برچسب اعمال کنید. اگر اطلاعات بدون برچسب زیادی داشته باشید و برچسب زدن بسیار وقت گیر و گران باشد ، این کار می تواند مفید باشد.

انتخاب ویژگی ها در کاهش

مهم ترین کار، کاهش ابعاد است. همچنین ، حذف برخی ابعاد و انتخاب متغیرهای مناسب تر برای مسئله.

در اینجا چند روش برای انتخاب متغیرها ذکر شده است :

- الگوریتم های حریصانه که متغیرها را حذف و اضافه می کنند تا زمانی که برخی از معیارها برآورده شوند.

- روش های کوچک کردن و جریمه کردن ، که هزینه های داشتن متغیرهای زیاد را افزایش می دهد. به عنوان مثال ، منظم سازی L1 ، ضریب برخی متغیرها را به صفر می رساند. منظم سازی ، فضایی را که ضرایب می توانند به آن تعلق داشته باشند، محدود می کند.

- ما باید مدل را بر اساس معیارهای خاص انتخاب کنیم و باید تعداد ابعاد را به حساب بیاوریم. مانند R² ، AIC یا BIC تنظیم شده. برخلاف منظم سازی ، این مدل برای بهینه سازی این معیارها آموزش داده نشده است.

- فیلتر کردن متغیرها با استفاده از همبستگی ، VIF یا برخی ” اندازه گیری فاصله ” بین ویژگی ها.

مزایای کاهش ابعاد

- کاهش ابعاد به فشرده سازی داده کمک می کند و از این رو فضای ذخیره سازی را کاهش می دهد.

- زمان محاسبه را کاهش می دهد.

- همچنین در صورت وجود ویژگی های زائد، منجر به حذف آن ها می شود.

- کاهش ابعاد به فشرده سازی داده ها و کاهش فضای ذخیره سازی مورد نیاز کمک می کند

- زمان مورد نیاز برای انجام محاسبات مشابه را تسریع می کند.

- اگر ابعاد کمتری وجود داشته باشد ، به محاسبات کمتری منجر می شود. همچنین ، ابعاد می توانند از الگوریتم های نامناسب برای تعداد زیادی از ابعاد استفاده کنند.

- این فرآیند، از هم خطی چندگانه که عملکرد مدل را بهبود می بخشد حفاظت می کند. همچنین ویژگی های زائد را حذف می کند. به عنوان مثال ، ذخیره یک مقدار در دو واحد مختلف ( متر و اینچ ) فایده ای ندارد.

- کاهش ابعاد داده به ۲ بُعد یا ۳ بُعد ممکن است به ما اجازه دهد آن را به طور دقیق ترسیم و تجسم کنیم. سپس می توانیم الگوها را با وضوح بیشتری مشاهده کنیم. در زیر می بینید که ، چگونه یک داده سه بعدی به ۲ بُعد تبدیل می شود. ابتدا ، نقشه ۲ بُعدی را شناسایی کرده و سپس نقاط موجود در این دو محور جدید z1 و z2 نشان داده می شود.

- در حذف نویز نیز مفید است و در نتیجه ، می توانیم عملکرد مدل ها را بهبود ببخشیم.

معایب کاهش ابعاد

- اساساً ممکن است منجر به از دست رفتن داده ها شود.

- اگرچه ، PCA تمایل دارد بین متغیرها همبستگی خطی پیدا کند ، که گاهی اوقات این کار نامطلوب است.

- همچنین ، PCA در مواردی که میانگین و کوواریانس برای تعریف مجموعه داده کافی نباشد ، موفق عمل نمی کند.

- بعلاوه ، ممکن است ندانیم که باید چند مولفه اصلی را نگه داریم – در عمل ، برخی قوانین سرانگشتی اعمال می شود.

بیایید نگاهی به ماشین های بردار پشتیان ( SVM ) داشته باشیم

خب ، همه این موارد مربوط به یادگیری کاهش ابعاد بود. امیدوارم توضیحات ما را بپسندید.

نتیجه گیری

بدین ترتیب، ما با فرآیند کاهش ابعاد آشنا شدیم. همچنین ، کلیه مفاهیم مربوط به کاهش ابعاد – یادگیری ماشین – انگیزه ، مولفه ها ، روش ها ، تحلیل مولفه های اصلی ، اهمیت ، تکنیک ها ، انتخاب ویژگی ها ، کاهش تعداد ، مزایا و معایب کاهش ابعاد را فرا گرفتیم. به عنوان یادگیری ماشین – کاهش ابعاد امروزه یکی از موضوعات داغ است. همچنین ، اگر سوالی در این زمینه داشتید، در قسمت نظرات بپرسید.

مجله هوش مصنوعی شهاب

مجله هوش مصنوعی شهاب