در سال ۱۹۵۶ جان مک کارتی یک پروژه تحقیقاتی با بازه زمانی ده هفته ای در دانشگاه دارتموث برگذار کرد که تمرکز آن روی مفهوم جدیدی به نام ” هوش مصنوعی ” بود. پژوهشگرانی که در این پروژه تحقیقیاتی شرکت کردند افرادی بودند که در پژوهش پدیده های نوظهور به نوعی غول علمی محسوب می شدند. از جمله این افراد ماروین مینسکی، ناتانیل روچستر، آلن نیول، او جی سلفریج، ریمونند سلیمانوف و کلود شانون بودند.

با این وجود واکنش ها نسبت به عبارت هوش مصنوعی بسیار در هم آمیخته است. آیا واقعا این عبارت توانسته است به خوبی مفهوم هوش مصنوعی را شرح بدهد؟ آیا راه بهتری برای توضیح دادن این کلمه وجود دارد؟

خب هیچ کسی نمی توانست برای توضیح این فناوری عبارت یا کلمه خوبی ارائه کند و در نهایت اصطلاح هوش مصنوعی بر روی آن باقی ماند.

از آن زمان تاکنون شاهد ساختن عبارات و کلمات بسیاری در این زمینه هستیم که اغلب فناوری ها و سیستم های پیچیده ای را تعریف می نمایند. و در نتیجه این تلاش ها می توان گفت درک و فهم آن چیزی که در مورد آن صحبت می شود واقعا دشوار است.

به همین دلیل برای درک واضح تر این عبارت با هم نگاهی بیندازیم به کلماتی که باید برای فهم بهتر عبارت هوش مصنوعی با آن ها آشنا شویم.

الگوریتم ( Algorithm )

Kurt Muehmel مدیر ارشد مشتریان Dataiku در این باره می گوید:

یک سری محاسبات که از ساده ترین قسمت آن ( تقسیمات طولانی با استفاده از قلم و کاغذ ) تا پیچیده ترین با استفاده از ابزار های محاسبات پیشرفته را در بر می گیرد برای مثال یادگیری ماشین ها با استفاده از یک الگوریتم برای پردازش داده ها و اطلاعات و کشف قوانینی که در اطلاعات پنهان شده اند صورت می گیرد و در نتیجه به صورت یک ” مدل ” کد نویسی می شود و می تواند برای پیش بینی اطلاعات جدید استفاده گردد.

یادگیری ماشین ( Machine Learning )

دکتر حسین رهنما که بنیان گذار و مدیر عامل شرکت Flybits است در این باره می گوید:

برنامه نویسی سنتی شامل مشخص کردن دنباله ای از دستورالعمل هایی است که این که کامپیوتر دقیقاً چه کاری را باید انجام دهد را به آن دیکته می کنند. بر خلاف آن، یادگیری ماشین یک الگوی برنامه نویسی متفاوت است که در آن مهندس، نمونه هایی را ارائه می دهد که مشخص می کند خروجی مورد نظر برنامه برای یک ورودی مشخص، چه می تواند باشد.

سپس سیستم یادگیری ماشین، مجموعه ای از تمام برنامه های رایانه ای ممکن را به منظور یافتن برنامه ای که نزدیک ترین خروجی مورد انتظار برای داده های ورودی مربوطه را تولید می کند، بررسی می نماید. در نتیجه ، با کمک این الگوی برنامه نویسی، مهندس نیازی به تشخیص نحوه آموزش کامپیوتر برای انجام یک کار ندارد، مشروط بر اینکه تعداد کافی از نمونه ها را برای سیستم داشته باشد تا بتواند برنامه صحیح را در فضای جستجو مشخص کند.

شبکه های عصبی ( Neural Networks )

دن گریم ، نائب رییس و مدیر کل بینایی کامپیوتر RealNetworks در این باره می گوید:

شبکه های عصبی، سازه های ریاضی ای هستند که از ساختار مغز انسان تقلید می نمایند تا اطلاعات پیچیده را به نتایج ساده و ملموس خلاصه کنند. دقیقاً مثل اینکه ما مغز انسان را آموزش می دهیم تا مثلاً یاد بگیریم بدن خود را برای پیاده روی کنترل کنیم، این شبکه ها نیز باید با مقادیر قابل توجهی از داده ها آموزش ببینند. در طول پنج سال گذشته ، پیشرفت های شگرفی در لایه بندی این شبکه ها و قدرت محاسباتی موجود برای آموزش آن ها به وجود آمده است.

یادگیری عمیق ( Deep Learning )

شلدون فرناندز مدیر عامل اجرایی شرکت DarwinAI می باشد در ارتباط با یاد گیری عمیق می گوید:

یادگیری عمیق یا یادگیری عمیق یک شکل تخصصی از آموزش ماشین است که مبتنی بر شبکه های عصبی است و توانایی های شناختی ذهن انسان را تقلید می کند. یادگیری عمیق همان مفهومی نسبت به یادگیری ماشین است که یادگیری ماشین برای هوش مصنوعی محسوب می شود و تنها تجلی والدین خود ( هوش مصنوعی و یادگیری ماشین ) نیست بلکه به طور کلی قدرتمند ترین و چشم نواز ترین نسخه می باشد. در عمل، شبکه های یادگیری عمیق که قادر به انجام کارهای پیچیده هستند شامل دو بخش می باشند

- بسیاری از لایه ها، عمیق با میلیون ها و گاهی اوقات میلیاردها ورودی هستند و به این خاطر یادگیری عمیقی دارند.

- با استفاده از نمونه های دنیای واقعی آموزش داده می شوند تا زمانی که در کار به خوبی مهارت پیدا کنند؛ و به این خاطر مهارت و یادگیری کافی دارند.

قابلیت توضیح ( Explainability )

مایکل بکلی ، که مدیر ارشد فنی و بنیانگذار کمپانی Appian است می گوید:

توضیح در این باره که چرا هوش مصنوعی کارت اعتباری شما را به عنوان کلاهبرداری، رد می کند و ادعای بیمه شما را انکار می کند یا سمت بغل کامیون را با یک آسمان ابری اشتباه می گیرد، قابلیت توضیح نام دارد. باید گفت برای ایجاد اعتماد و شفافیت در نرم افزارهای مبتنی بر هوش مصنوعی، باید قابلیت توضیح را ایجاد کرد.

قدرت و پیچیدگی هوش مصنوعیِ یادگیری عمیق، می تواند توضیح چگونگی پیش بینی و تصمیم گیری را برای مشتریان و تنظیم کنندگان سخت کند. همانطور که درک ما از ظرفیت و پتانسیل مجموعه داده ها که برای آموزش الگوریتم های هوش مصنوعی استفاده می شود بیشتر می شود، نیاز به توضیح بیشتری در سیستم های هوش مصنوعی نیز افزایش می یابد. برای برطرف کردن این چالش، شرک تها می توانند از ابزاری مانند Platforms Low Code استفاده نمایند تا انسان را در حلقه خود قرار داده و نحوه استفاده از هوش مصنوعی در تصمیمات مهم را تعیین کنند.

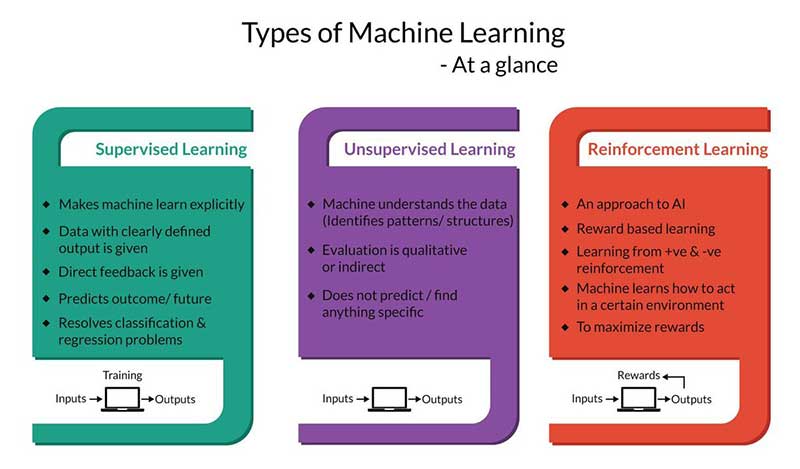

یادگیری نظارت شده، بدون نظارت و یادگیری تقویتی

جاستین سیلور مدیر علوم و تحقیقات کمپانی PROS می گوید:

سه قسمت گسترده از یادگیری ماشین وجود دارد: یادگیری نظارت شده، بدون نظارت و یادگیری تقویتی.

در یادگیری نظارت شده ( Supervised Learning ) دستگاه مجموعه ای از موارد را مشاهده می کند (به عنوان “موارد” به عنوان سناریوهایی مانند “هوا سرد و بارانی است”) و پیامدهای آن ها (مثلاً “جان به ساحل می رود”) و قوانین را با آن یاد می گیرد. هدف از اینکه بتوانیم نتایج موارد غیرقابل پیش بینی را پیش بینی کنیم (اگر در گذشته معمولاً جان هنگام سرما و باران به ساحل رفته باشد، در آینده دستگاه پیش بینی می کند که جان به احتمال زیاد هر وقت که هوا سرد و بارانی است به ساحل می رود).

در یادگیری بدون نظارت ( Unsupervised Learning ) دستگاه مجموعه ای از موارد را مشاهده می کند بدون اینکه هیچ نتیجه ای را برای این موارد مشاهده کند، الگوها یاد می گیرد که به آن این امکان را می دهد تا پرونده ها را به گروه هایی با مشخصات مشابه طبقه بندی کند (بدون هیچ آگاهی از اینکه جان به ساحل رفته است، دستگاه یاد می گیرد که “هوا سرد و بارانی است” شبیه به “بارش برف است” اما نه “هوای بیرون گرم است”)

در یادگیری تقویتی ( Reinforcement Learning )، دستگاه برای دستیابی به یک هدف اقدامات لازم را انجام می دهد، از آن اقدامات بازخورد دریافت می کند و از طریق آزمایش و خطا می آموزد که اقداماتی انجام دهد که منجر به تحقق بهتر آن هدف می شود (اگر دستگاه در تلاش است تا به جان کمک کند تا از روز هی سرد و بارانی ساحل در امان باشد، در این مورد می تواند به او پیشنهاد دهد که جان چه ساعاتی را برای رفتن به ساحل انتخاب کند و همینطور از بازخورد مثبت و منفی جان بیاموزد و پیشنهادات خود را به روزرسانی کند).

بایاس (Bias )

مهول پاتل مدیرعامل اجرایی شرکت hired می گوید:

در حالی که شما احتمالا ماشین ها را عینی، عادلانه و منسجم تصور می کنید اما در واقع آن ها بیشتر همان تعصبات ( بایاس ) ناخودآگاه را همانند انسان هایی که آن ها را ساخته اند، تصویب می کنند. به همین دلیل لازم است که شرکت ها اهمیت عادی سازی داده ها را – یعنی تنظیم مقادیر اندازه گیری شده در مقیاس های مختلف در مقیاس معمول – تشخیص دهند تا اطمینان حاصل شود که تعصبات انسانی ناخواسته وارد الگوریتم نمی شوند.

به عنوان نمونه اگر شما بخواهید نیرو استخدام کنید و از رایانه بدین منظور استفاده نمایید: اگر مجموعه ای از داده ها و ۱۰۰ زن و ۳۰۰ مرد کاندیدا را به رایانه ارائه دهید و از آن بخواهید بهترین فرد را برای این کار پیش بینی کند، قرار است نامزدهای مرد بیشتری را تحت پوشش خود قرار دهد زیرا حجم مردان سه برابر اندازه زنان در مجموعه داده ها است. در نتیجه ساختن فناوری عادلانه و عینی ممکن است چالش برانگیز باشد اما مطمعنا الگوریتم های آگاه سازی در مورد تصمیمات و بینش های ما و تعصباتی را که ما سعی در خنثی کردن آن ها به عنوان یک جامعه داریم در پی ندارد.

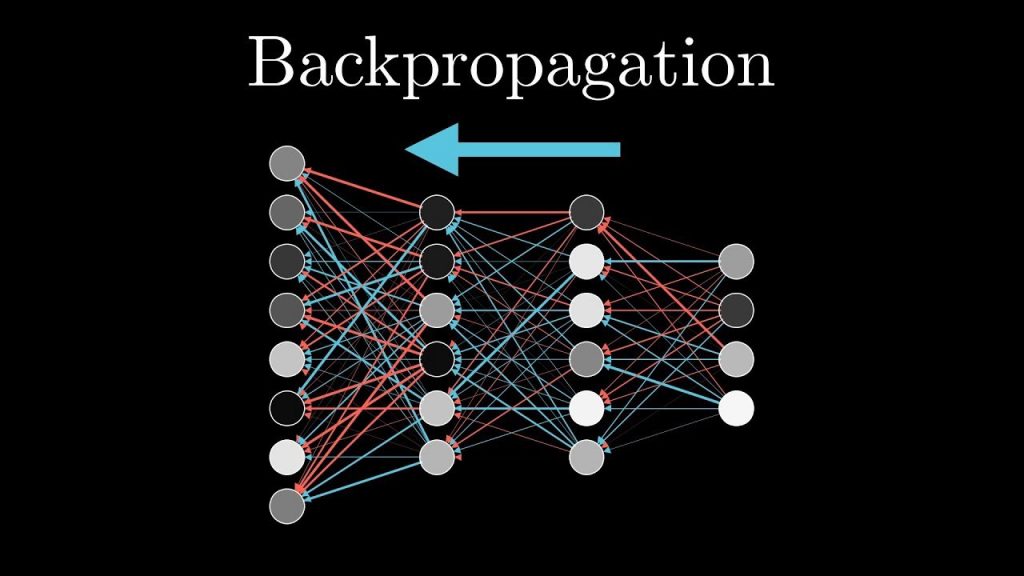

پس انتشار خطا ( Backpropagation )

ویکتوریا جونز کسی است که در کمپانی Zoho AI Evangelist فعالیت می کند می گوید:

الگوریتم های پس انتشار خطا ( backpropagation ) به یک شبکه عصبی اجازه می دهند تا از اشتباهات آن درس بگیرد. این فناوری رویداد را از قبل از نتیجه اش پیش بینی و تجزیه و تحلیل می کند و میزان خطا را در مراحل مختلف برای تنظیم پیش بینی بعدی خود به کار می برد.

حدود ۷۰٪ دستیار یا کمک کننده هوش مصنوعی ما (به نام Zia) از ویژگی backpropagation یا انتشار خطا استفاده می کنند که شامل موتور بررسی گرامر Zoho Writer و فناوری نویسه خوان (OCR) Zoho Notebook ، که به Zia اجازه می دهد تا اشیاء موجود در تصاویر را شناسایی کرده و آن تصاویر را جستجو کند. این فناوری همچنین به چت روم Zia امکان پاسخگویی دقیق تر و طبیعی تر را می دهد. هرچقدر که تجارت بیشتر از Zia استفاده نماید، Zia بیشتر درک می کند که چطور این تجارت انجام می گردد. این موضوع به این معنی است که قابلیت های تشخیص و پیش بینی ناهنجاری Zia برای هر تجارت خاص دقیق تر و شخصی تر می شوند.

پردازش زبان طبیعی ( NLP )

کورتنی ناپول ، که مدیر دانش زبانی در کمپانی گرامرلی Grammarly می گوید:

موضوع پردازش زبان طبیعی، هوش مصنوعی، علوم کامپیوتر و زبانشناسی را با هدف آموزش و یادگیری ماشین برای ماشین ها جهت درک و پردازش زبان انسان گرد هم آورده است. محققان و مهندسان پردازش زبان طبیعی برای انجام انواع وظایف زبانی از جمله ترجمه ماشینی، آنالیز احساسات و تقویت نوشتاری، مدل هایی را برای رایانه ها تولید کرده اند. محققان به طور معمول با تجزیه و تحلیل مفاهیم متن آغاز می کنند و مجموعه بزرگی از جملات هستند که به شکل هایی سازمان یافته و حاشیه نویسی شده می باشند و به گونه ای که الگوریتم های هوش مصنوعی بتوانند آن را بفهمند ساخته شده اند.

آموزش ماشین آلات برای درک زبان انسان مشکل بسیار خلاقانه و پیچیده ای است و به ظهور خود هوش مصنوعی بر می گردد. زبان در طول هزاره ها پیدا کرده است و ابداع روش هایی برای به دست آوردن این جنبه صمیمی از فرهنگ انسانی وظیفه ای ویژه و چالش برانگیز پردازش زبان طبیعی است که نیاز به سطوح حیرت انگیزی از مهارت ، دقت و تشخیص دارد. با نزدیک شدن هوش مصنوعی (مخصوصاً یادگیری ماشین و زیر مجموعه آن که به عنوان یادگیری عمیق شناخته می شود) در طی چند سال گذشته گسترش یافته است. علم پردازش زبان طبیعی وارد یک دوره بی نظم و آشفته ای شده است که از امکانات جدید برای تجزیه و تحلیل زبان در مقیاسی بی سابقه استفاده می نماید و همینطور باید گفت وجود ابزارهای ساختمان بندی شده ی آن با سطحی از پیچیدگی بیانی به گونه ای است که در حدود یک دهه قبل تصور آن غیر ممکن بود.

این مطلب توسط تام تاولی (@ttaulli) نویسنده کتاب Artificial Intelligence Basics: A Non-Technical Introduction ارائه شده است.

در ادامه از برای آشنایی بیشتر با اصطلاحات حوزه هوش مصنوعی و نحوه ی ارتباط آن ها، پیشنهاد می کنیم از ویدیو زیر دیدن کنید.

بیشتر بخوانید :

- فناوری تشخیص پلاک خودرو چگونه جامعه را هوشمندتر می کند

- گوگل ساختار سازمانی خود را جهت تمرکز بر هوش مصنوعی اصلاح می کند

- پلاک خوان های شهر گرینزبوروی آمریکا فعلاً قرار نیست افزایش پیدا کنند

- فرماندار اوکلند از پلاک خوان ها حمایت می کند اما مخالفان در اثربخشی آن تردید دارند

- لبنان استفاده از پلاک خوان های خودکار را تایید کرد

مجله هوش مصنوعی شهاب

مجله هوش مصنوعی شهاب

خیلی خوب بود ممنون ازتون