آخرین دستاورد IBM در جهت ملموس تر ساختن هوش مصنوعی برای جهان، یک جعبه ابزار از الگوریتم هاست که می تواند برای توضیح تصمیمات برنامه های یادگیری ماشین استفاده بشود. حال یک سوال عمیق پیش می آید: توضیح درست چیست و چطور ما می توانیم یک توضیح را پیدا کنیم که مورد قبول باشد؟

دهه ها پیش از این که شبکه های عصبی یادگیری عمیق امروز، فرایند پردازش لایه هایی بیشماری از آمارها را به ماشین های کار آمد تبدیل کنند، محققان سعی می کردند تا کشف کنند چگونه می توان یافته های آماری را به یک انسان توضیح داد.

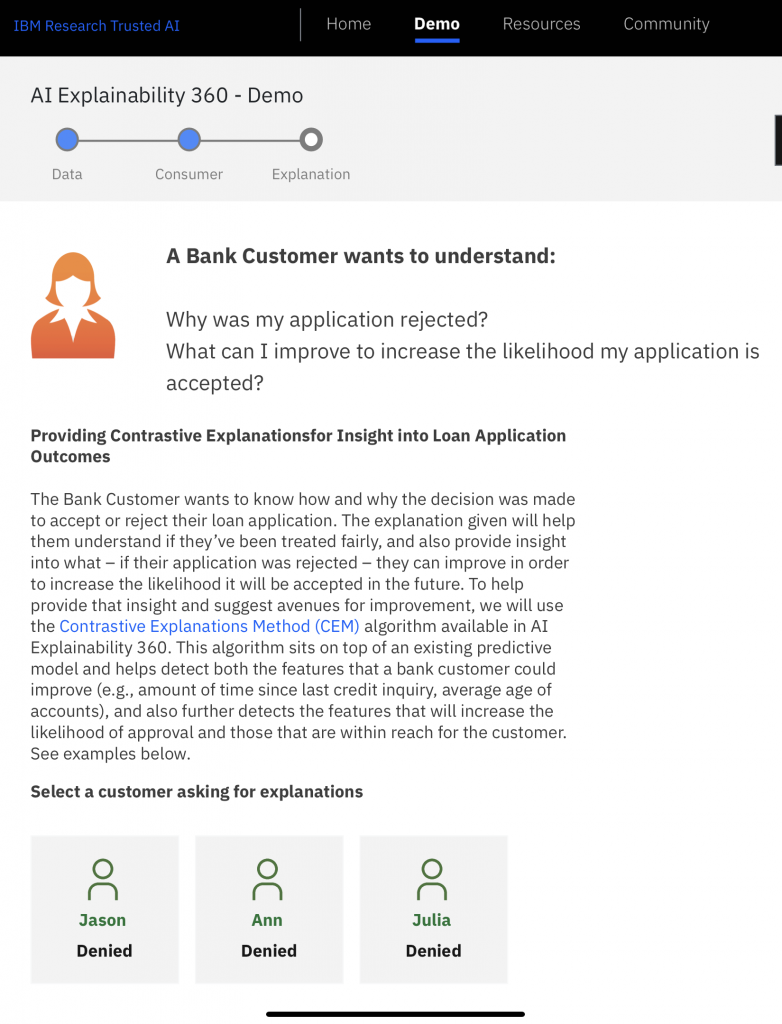

IBM در ماه آگوست ۲۰۱۹، آخرین تلاش در زمینه ی این تحقیق طولانی برای تفسیر ، توضیح و توجیه یادگیری ماشین را ارائه کرد؛ یک مجموعه از منابع برنامه نویسی متن باز به نام “ Al 360 Explainability ”.

هنوز باید ببینیم که آیا ابزار دیگری، این معما که وقتی هوش مصنوعی یک پیش بینی براساس داده ها خلق می کند، مردم چطور می توانند بفهمند که در آن چه می گذرد را حل خواهند کرد یا خیر.

جعبه ابزار شامل ۸ الگوریتم مختلف است که در طی سال ۲۰۱۸ منتشرشده اند. ابزار های IBM بر روی گیت هاب به عنوان یک کتابخانه ی پایتون، پست می شوند. پروژه در یک پست وبلاگ توسط IBM Fellow Aleksandra Mojsilovic گذاشته شده است.

انگیزه این کار برای هرکسی روشن است. یادگیری ماشین درحال در بر گرفتن سطوح بیشتری از زندگی ست، و جامعه می خواهد بداند چطور این قبیل برنامه ها در پیشگویی هایی که می تواند سیاست، تشخیص های پزشکی و غیره را تحت تاثیر قرار بدهد، موفق می شوند.

امروزه موارد منفی نامعتبر و گمراه کننده در مورد هوش مصنوعی، مرتب در حال تکرار است. مطالعه ای توسط مایکروسافت در سال ۲۰۱۵ یک مدل یادگیری ماشین را شرح می دهد که متوجه شده است بیماران پنومونی (ذات الریه) در بیمارستان ها که از آسم نیز رنج می برند، نسبت به دیگر بیماران روند بهبودی بهتری دارند. این یافته به نظر می رسید به این معناست که ذات الریه به علاوه ی آسم در معرض خطر کمتری است و در نتیجه چنین بیمارانی می توانند مرخص شوند.

با این وجود، این پیشبینی که با اطمینان بالاتر از حد متوسط ارائه شده بود، در واقع نتیجه ی این است که از لحاظ تاریخچه بیماران، افرادی مبتلا به آسم نیز بوده اند، مرخص نشده بودند، اما در عوض اولویت بالاتری به آن ها داده شد و درمان شدید تری در ICU دریافت می کردند، تنها به این دلیل که آن ها در معرض خطر بیشتر بودند، نه خطر کمتر. این یک روایت هشدارآمیزاست در مورد اینکه چگونه یادگیری ماشین می تواند فقط برای دلایل اشتباه، به اشتباه پیش بینی کند.

انگیزه این کار واضح است، اما مسیر رسیدن به توضیحات واضح و روشن نیست. چالش اصلی به اصطلاح هوش مصنوعی قابل توضیح، که یک عرصه ی در حال گسترش در سال های اخیر است، تصمیم گیری این است مفهوم قابل توضیح بودن، چیست. اگر کسی برای خدمت به مثلا یک کاربر غیر فنی، توضیحات را خیلی ساده کند، این توضیح شاید جزئیات مهم در مورد برنامه های یادگیری ماشین را مبهم کند. اما در مجموع، بحث پیچیده از آنچه در یک شبکه ی عصبی در جریان است ممکن است در نزد آن فرد غیرفنی کاملا بی نتیجه باشد.

به این خاطر که قدرتمندترین شبکه های عصبی از انواع یادگیری عمیق، صحت خودشان را اغلب همانند یک دستاورد از کمتر قابل فهم شدن روی بررسی به دست آورده اند، مشکل دیگر چگونه متعادل کردنِ نیازمندی برای قابلیت فهم پذیری، با نیاز برای دقت بیشتر است.

محققانِ خود IBM، چالش عظیمی را توضیح داده اند که با هر گونه تلاش برای توضیح یا توجیه و یا تفسیر سیستم های یادگیری ماشین رو به رو می شود، مخصوصا وقتی که دریافت کنندگان توضیحات گفته شده، مشتریان غیرفنی سیستم هستند.

به عنوان مثال Michael Hind، یک مهندس ارشد موسسه ی تحقیقات IBM، در انجمن محاسبات ماشین آلات مجله ی XRDS امسال نوشت، این که یک توضیح مناسب چیست، به طور کامل واضح نیست، حتی بین انسان ها. اگر در اغلب اوقات دقت مهم ترین چیز هست، با احترام به یک مدل یادگیری ماشین، “ چرا ما تقاضاهای بالاتری برای سیستم های هوش مصنوعی داریم” نسبت به نحوه ی تصمیم گیری انسان ها.

همانطور که توسط دانشمند پژوهش Or Biran در استارت آپ هوش مصنوعی Elemental Cognition مستقر در کانکتیکات ، تلاش ها برای تفسیر یا توضیح و یا توجیه یادگیری ماشین حدود چندین دهه بوده است ، که در سال های گذشته به “سیستم های خبره ” خیلی ساده تری رسیده است.

Biran نوشت ، مشکل این است که پیچیدگی یادگیری عمیق در سرپیچی از تفسیر آسان است: “تلاش های کنونی با مشکلات بی سابقه مواجه هستند: مدل های جدید پیچیده تر و کمتر از همیشه قابل تفسیر هستند. “

تلاش ها در طول سال ها به ۲ راهبرد اساسی میسر شده است: ۱) برای رسیدن به این هدف، آزمایش های مختلف به منظور تلاش برای توضیح مدل یادگیری ماشین، انجام گیرد ۲) ساخت برنامه های یادگیری ماشینی که از ابتدا برای توضیح، واضح تر هستند. الگوریتم های نمونه در جعبه ابزار IBM، که در مقالات پژوهشی در طول سال ۲۰۱۸ معرفی شدند ، شامل هر دو روش هست. (در تکمیل نوشته ی Biran که در بالا ذکر شد, یک بررسی عالی از روش های تفسیر و توضیح یادگیری عمیق را می توان در یک مقاله در سال ۲۰۱۷ توسط Gregoire Montavona و همکاران دانشگاه فنی در برلین یافت.)

به عنوان مثال ، “ProtoDash “، الگوریتمی که توسط Karthik S. Gurumoorthy و همکارانش در IBM توسعه یافته ، یک رویکرد جدید برای یافته ی “نمونه های اولیه ” در یک برنامه ی یادگیری ماشین موجود، است. یک نمونه ی اولیه را می توان به عنوان یک زیر مجموعه از داده هایی که تاثیر بیشتری روی قدرت پیش بینیِ مدل دارند، تصور کرد. هدف نمونه ی اولیه، گفتن چیزی مشابه این است که اگر شما این نقاط داده را حذف کنید، مدل به خوبی عمل نمی کند. به این صورت شخص می تواند پیش بینی های پویا را بفهمد.

Gurumoorthy و همکاران یک رویکرد جدید را ارائه دادند که درآن، تعداد انگشت شماری از نقاط در داده ها را، به طور بالقوه از میان میلیون ها نقاط داده جدا می کند؛ با پیشبینی این که شبکه های عصبی در حال انجام چه کاری هستند.

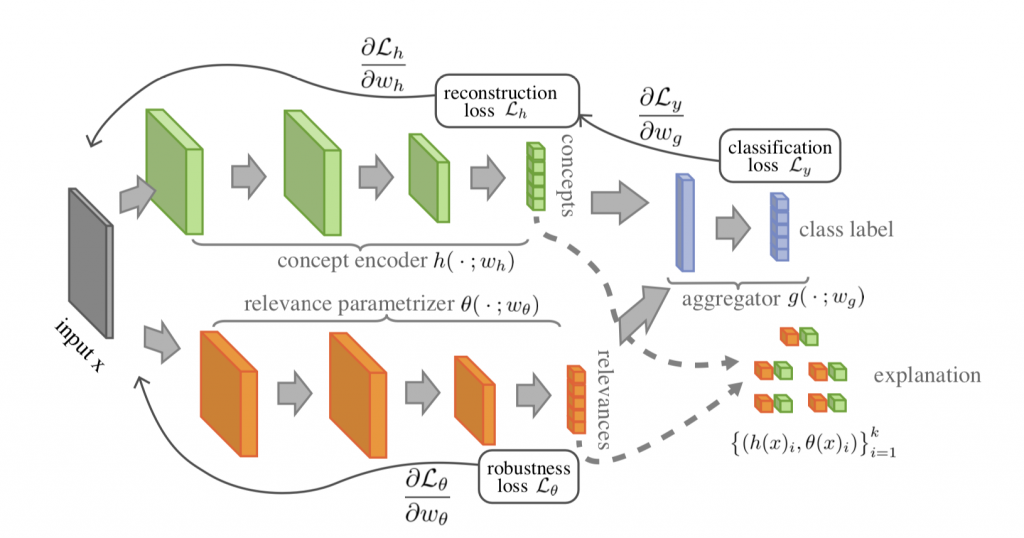

David Alvarez-Melis و Tommi S. Jaakkola در کار دیگری ، که آن را در جهت عکس قضیه به دست آورده اند ، یک مدل “خود توضیح ” را ایجاد کردند، با شروعِ از رگرسیون خطی که قابلیت تفسیر شبکه در حالی که شبکه برای اطمینان حاصل کردن از اینکه نقاط ورودی داده ها به صورت محلی کاملا نزدیک به یکدیگر هستند پیچیده تر شده است. آن ها استدلال کردند که این رویکرد باعث نتیجه ی قابل تفسیر مرتب اما همچنین قدرتمند می شود .

نیازی به گفتن نیست ، هیچ یک از این الگوریتم های مختلف راه حل های خلاصه شده ای برای ساخت یادگیری ماشین مناسب با انتظارات برای توضیح اینکه چه اتفاقی در حال رخ دادن است، نیست. برای به انجام رساندن آن، شرکت ها مجبورند ابتدا تعیین کنند چه نوع توضیحی انتقال داده خواهد شد، و برای چه منظور، و سپس کار سخت استفاده از جعبه ابزار را برای امتحان و ساخت هرچیز کاربردی که درخور آن الزامات است را انجام بدهند.

بده بستان های مهمی در رویکردها وجود دارد. یک مدل یادگیری ماشین که قوانین صریح پخته شده ای دارد، به عنوان مثال آنچه که به عنوان “تجزیه پذیری ” شناخته شده است، ممکن است برای یک کاربر غیر فنی فهمیدنش آسان تر باشد ، اما این شاید برای یک دانشمند داده برای مهندسی معکوس کردن به منظور تست اعتبار، سخت تر باشد.

IBM برخی از آموزش ها را برای کمک به این روند ارائه کرده است. مستندات کامل API نیز شامل معیارهایی است که می سنجد اگر ویژگی هایی که تصور می شود برای تفسیر مهم ترین باشند از یک برنامه یادگیری ماشین حذف شوند، چه اتفاقی می افتد. آن را به عنوان راهی برای ارزیابی توضیحات در نظر بگیرید.

و یک نسخه ی آزمایشی برای پوشش این سوال که چه کسی که هدف مخاطب برای توضیحات است، ارائه شده است. از یک کاربر کسب و کار گرفته تا یک مصرف کننده تا یک دانشمند داده .

حتی با اهداف شناخته شده، دانشمندان داده مجبور خواهند بود اهدافی با قابلیت توضیح را به دیگر جنبه های فنیِ یادگیری ماشین نزدیک کنند که ناهماهنگی های جدی ای می تواند به وجود آید. به عنوان مثال، طرح کردن روش هایی مانند نمونه های اولیه و یا محاسبات خطی محلی در دو مطالعه ذکر شده در بالا می تواند به طور بالقوه در تضاد با برخی جنبه های شبکه های عمیق عصبی مانند “هنجارسازی ” که در آن شبکه ها برای جلوگیری کردن از مشکلاتی مانند ” covariate shift “(تغییر متغیر کمکی) ساخته شده است، باشد .

سخن نهایی این است که هوش مصنوعی قابل تفسیر، قابل توضیح و شفاف ، به عنوان یک حوزه در حال گسترش در یادگیری ماشین، چیزی نیست که کسی به سادگی با تلنگر یک سوئیچ آن را به جریان بیندازد. این خودش به تنهایی زمینه ای از تحقیقات اساسی است که نیاز به ادامه اکتشافات دارد. گرفتن یک جعبه ابزار از آی بی ام فقط آغاز کاری دشوار است.

بیشتر بخوانید :

- هوش مصنوعی مولد تهدیدات جدیدی برای امنیت سایبری ایجاد می کند

- فناوری تشخیص پلاک خودرو چگونه جامعه را هوشمندتر می کند

- گوگل ساختار سازمانی خود را جهت تمرکز بر هوش مصنوعی اصلاح می کند

- پلاک خوان های شهر گرینزبوروی آمریکا فعلاً قرار نیست افزایش پیدا کنند

- فرماندار اوکلند از پلاک خوان ها حمایت می کند اما مخالفان در اثربخشی آن تردید دارند

مجله هوش مصنوعی شهاب

مجله هوش مصنوعی شهاب