در حال حاضر، ارائه دهندگان فناوری ابری، برای برنامه یادگیری ماشین شما ، گزینه های زیادی ارائه می کنند. AWS ، Alibaba cloud ، Azure و Huawei ، چندین پلتفرم مانند CPU های چندمنظوره ، CPU های بهینه شده برای محاسبات ، CPU های بهینه شده برای حافظه ، GPU ، FPGA و واحدهای پردازش TensorFlow ( TPU ) را ارائه می دهد.

انتخاب یکی از این پلتفرم ها به منظور دستیابی به بهترین عملکرد و هزینه کمتر ، یک کار چالش برانگیز است و نیاز به بررسی و برنامه ریزی دقیق دارد. با این وجود، نکاتی وجود دارد که می تواند به شما کمک کند تا در مورد بهترین پلتفرم برای برنامه های خود، تصمیم گیری ساده تری داشته باشید. در این مقاله یک توضیح سریع و خلاصه در مورد نحوه انتخاب بهترین پلتفرم برنامه های تان، ارائه می شود.

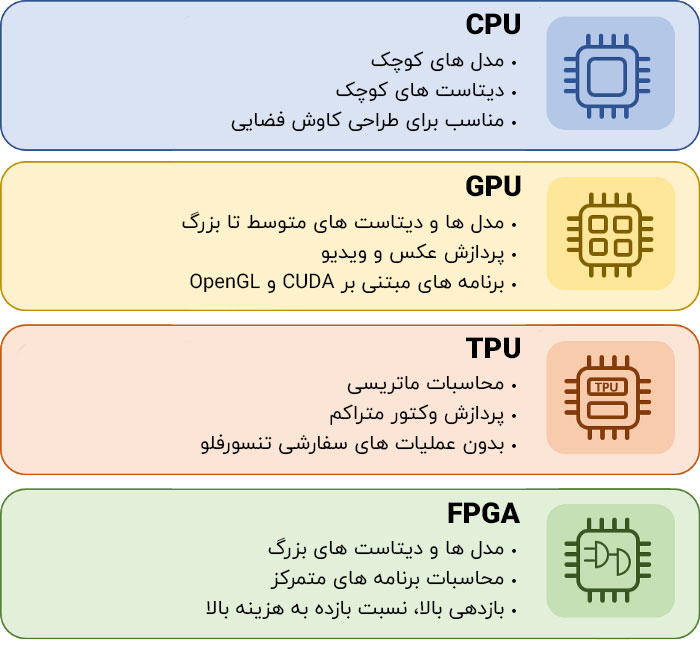

چه زمانی از CPU استفاده کنید :

مهم ترین مزیت CPU ها این است که برنامه نویسی آن ها بسیار آسان است و از هر چارچوب برنامه نویسی پشتیبانی می کنند. شما می توانید برنامه آن ها را درC/C++ ، Scala ،Java ، Python یا هر زبان جدید دیگری بنویسید. جستجوی سریع فضای طراحی و اجرای برنامه ها ، از این طریق، بسیار آسان است. با این حال ، هنگامی که صحبت از آموزش یادگیری ماشین است ، برای مدل های ساده که آموزش چندانی ندارند و مدل های کوچک با اندازه دسته های کوچک، بسیار مناسب است. اگر می خواهید مدل های بزرگ و مجموعه داده های بزرگ را اجرا کنید ، زمان اجرای کل برای آموزش یادگیری ماشین غیر قابل قبول خواهد بود.

چه زمانی از GPU استفاده کنید:

GPU ها واحدهای پردازش تخصصی هستند که عمدتاً برای پردازش تصاویر و فیلم ها طراحی شده اند و در مقایسه با CPU ها، مبتنی بر واحدهای پردازش ساده تری هستند، اما می توانند تعداد هسته های بسیار بیشتری را در اختیار داشته باشند و آن ها را برای برنامه هایی که در آن، داده ها به صورت موازی پردازش می شوند; مانند پیکسل های تصاویر یا فیلم ها ، ایده آل می کنند. با این حال ، GPU ها به زبان هایی مانند CUDA و OpenCL برنامه نویسی می شوند ، در نتیجه در مقایسه با CPU ها، انعطاف پذیری محدودی دارند.

چه زمانی از TPU استفاده کنیم:

واحدهای پردازش Tensorflow از پایین به بالا طراحی شده اند تا اجرای سریع تر برنامه، امکان پذیر شود. TPU ها در انجام محاسبات برداری و ماتریسی بسیار سریع عمل می کنند و در اجرای یک برنامه بسیار سریع مبتنی بر Tensorflow ، تخصص دارند. آن ها برای برنامه های تحت محاسبات ماتریسی و برای برنامه ها و مدل های بدون عملیات سفارشی TensorFlow در حلقه اصلی آموزش، بسیار مناسب هستند. این بدان معنی است که آن ها انعطاف پذیری کمتری در مقایسه با CPU ها و GPU ها دارند و استفاده از آن ها ، فقط برای مدل های مبتنی بر TensorFlow ، منطقی است.

چه زمانی از FPGA استفاده کنید:

در FPGA های قدیمی یک تراشه قابل پیکربندی وجود داشت که عمدتا برای اجرای منطق چسبی ( Glue Logic ) و توابع سفارشی به کار می رفت. با این حال ، در حال حاضر FPGA به عنوان یک واحد پردازش بسیار قدرتمند ظاهر شده است که می تواند برای پاسخگویی به نیاز برنامه ها، پیکربندی شود. در حقیقت ، با استفاده از FPGA می توان معماری های سفارشی را برای برنامه های خاص، طراحی کرد.

به این ترتیب می توانیم در مقایسه با گزینه های دیگر مانند CPU ها و GPU ها ، به کارایی بالاتر، هزینه کم تر و مصرف توان پایین تر دست یابیم. FPGA ها را می توان در حال حاضر با استفاده از OpenCL و سنتز سطح بالا ( HLS) برنامه ریزی کرد و این باعث می شود که برنامه بسیار ساده تر از گذشته باشد. با این حال، با توجه به این محدودیت، FPGA ها ، نسبت به پلتفرم های دیگر، انعطاف پذیری محدودی ارائه می دهند.

بهترین راه استفاده از FPGA برای آموزش یک مدل، استفاده از معماری از پیش تنظیم شده برای برنامه های مورد علاقه شماست. به این ترتیب می توانید عملکرد بسیار بالاتری نسبت به CPU ها و GPU ها بدست آورید و در عین حال مجبور نیستید کد خود را به طور کلی تغییر دهید. معماری های پر شتاب از پیش تنظیم شده ، کلیه API ها و کتابخانه های مورد نیاز را برای چارچوب برنامه نویسی شما (Python ، Scala ، Java ، R و Apache Spark ) فراهم می کند که به شما اجازه می دهد تا بیشترین کار های محاسباتی فشرده سازی شده را بارگذاری کرده و آن ها را به FPGA انتقال دهید. به این ترتیب ، شما بهترین عملکرد را به دست می آورید و لازم نیست برنامه های خود را بر روی یک بستر / چارچوب خاص مانند TensorFlow بنویسید. این رویکردی است که در InAccel دنبال می شود.

InAccel یک مجموعه یکپارچه را توسعه داده که هم شامل معماری FPGA بهینه سازی شده برای آموزش یادگیری ماشین است و هم پشته نرم افزاری که اجازه یکپارچه سازی بدون درز شتاب دهنده های سخت افزاری را بدون نیاز به تغییر کد شما فراهم می کند. و موفق شده اند که آن را در یک کانتینر Docker ادغام کنند که استقرار و استفاده را بسیار آسان تر می کند.

این پلتفرم یکپارچه، به متخصص علم داده، اجازه می دهد تا مدل های یادگیری ماشین خود را براساس رگرسیون لجستیک ، خوشه بندیK – means یا موتورهای توصیه گر بر روی چارچوب های برنامه نویسی پرطرفدار مانند Scala، Python وSpark ML ، حداکثر ۳ برابر سریع تر آموزش دهد. حالا که FPGA ها روی ابر موجود هستند، سرعت بخشیدن به برنامه های یادگیری ماشین ، بدون نیاز به خرید FPGA شخصی خودتان، آسان تر از همیشه است.

شما می توانید با استفاده از مجموعه InAccel Accelerated ML suite در AWS عملکرد آموزش یادگیری ماشین خود را بر روی ابر بررسی کنید و بررسی کنید که آموزش، چگونه مدل را ۳ برابر تسریع می کند.

مقایسه سریع : مشکلات و اشتباهات

موقع انتخاب یک پلتفرم سخت افزار برای اجرای برنامه تان ، باید توجه بیشتری به نتایج معیار ها و مقایسه با پلتفرم های دیگر داشته باشید. مقایسه بین پلتفرم ها همیشه باید با استفاده از مجموعه داده های یکسان، تحت چارچوب (مثل Mahout ، Spark و غیره) انجام شود و باید همیشه از نسخه بهینه CPU ها استفاده کند.

این بدان معنی است که طراحی مرجع باید همیشه نسخه بهینه CPU با استفاده از کتابخانه های بهینه برای کاربرد های خاص باشد (به عنوان مثال برای یادگیری ماشین، بسیاری از چارچوب ها ، از کتابخانه BLAS بهینه سازی شده برای آموزش یادگیری ماشین استفاده می کنند).

اگر مقایسه سرعت با استفاده از یک مرجع ساده Scala یا Python پیاده سازی شود، این امر منجر به نتیجه گیری های گمراه کننده خواهد شد. به عنوان مثال، نوشتن یک نسخه بهینه از الگوریتم خاص در C / C + +، حتی برای پلتفرم با همان عملکرد یا پایین تر، مزیت قابل توجهی را ارائه خواهد کرد. بنابراین، مقایسه ، همیشه باید با استفاده از بهینه ترین نسخه از چارچوب های CPU انجام شود تا نتیجه گیری مفیدی حاصل شود.

بیشتر بخوانید :

- پلاک خوان های شهر گرینزبوروی آمریکا فعلاً قرار نیست افزایش پیدا کنند

- فرماندار اوکلند از پلاک خوان ها حمایت می کند اما مخالفان در اثربخشی آن تردید دارند

- لبنان استفاده از پلاک خوان های خودکار را تایید کرد

- چالش های مدیریت کلاس با ابزار جدید تشخیص چهره هوش مصنوعی

- آیا می توان از دوربین های ترافیکی برای گرفتن رانندگان الکلی استفاده کرد؟

مجله هوش مصنوعی شهاب

مجله هوش مصنوعی شهاب