خطرات هوش مصنوعی : در این مقاله به بررسی خطرات هوش مصنوعی می پردازیم و جنبه های تاریک و چالش های این تکنولوژی قدرتمند را مورد بحث قرار می دهیم. با ما همراه باشید تا با آگاهی بیشتر به استقبال آینده هوش مصنوعی برویم.

این مقاله ای که در حال مطالعه آن هستید، در واحد تولید محتوای شرکت شهاب، با دغدغه مندی و نگاهی انتقادی به دنیای تکنولوژی و هوش مصنوعی، تهیه و تولید شده است. هدف ما این هست که با افزایش آگاهی شما در مورد خطرات هوش مصنوعی، به استفاده مسئولانه و اخلاقی از این تکنولوژی کمک کنیم. پس با ما همراه باشید! 🧐

خطرات هوش مصنوعی

هوش مصنوعی مثل یه شمشیر دولبه هست! از یه طرف، می تونه به ما در حل بسیاری از مشکلات و چالش ها کمک کنه و زندگی ما رو بهتر کنه. اما از طرف دیگه، خطرات هوش مصنوعی هم قابل انکار نیستن.

خطرات هوش مصنوعی می تونن ابعاد مختلفی داشته باشن، از مسائل اخلاقی و اجتماعی گرفته تا تهدیدات امنیتی و اقتصادی. برای مثال، الگوریتم های متعصب، بیکاری فناورانه، سلاح های خودمختار و جعل عمیق (deepfake) تنها چند نمونه از خطرات هوش مصنوعی هستند.

در این مقاله، می خوایم با هم به ابعاد مختلف خطرات هوش مصنوعی نگاهی بیندازیم و با چالش های پیش رو آشنا بشیم. پس با ما همراه باشید! 🔎

تعصب در الگوریتم ها (Algorithmic Bias)

تبعیض الگوریتمی چیست؟

یکی از مهم ترین خطرات هوش مصنوعی، تعصب در الگوریتم ها هست. الگوریتم های هوش مصنوعی با استفاده از داده ها آموزش داده می شن. اگر این داده ها دارای تعصب باشن، الگوریتم هم متعصب خواهد بود و می تونه منجر به تبعیض در زمینه های مختلف بشه.

یه سوال: تعصب در الگوریتم ها چه مشکلاتی ایجاد می کنه؟ 🤔

جواب: تعصب در الگوریتم ها می تونه منجر به تبعیض در زمینه هایی مثل استخدام، قضاوت، پزشکی و حتی سیستم های نظارتی بشه. برای مثال، یه الگوریتم استخدام که با داده های متعصب آموزش داده شده باشه، ممکن هست افراد متعلق به گروه های خاصی رو به طور ناعادلانه رد کنه.

چگونه با تعصب در الگوریتم ها مقابله کنیم؟

برای مقابله با این خطر، باید از داده های متنوع و بدون تعصب برای آموزش الگوریتم ها استفاده کنیم. همچنین، باید الگوریتم ها رو به طور دائم مورد بررسی و ارزیابی قرار بدیم تا از وجود تعصب در اون ها مطمئن بشیم.

بیکاری فناورانه (Technological Unemployment)

آیا ربات ها شغل ما را می گیرند؟

یکی دیگه از خطرات هوش مصنوعی، بیکاری فناورانه هست. با پیشرفت هوش مصنوعی و خودکارسازی وظایف، ممکن هست بسیاری از مشاغل توسط ربات ها و سیستم های هوش مصنوعی انجام بشن. این موضوع می تونه منجر به بیکاری گسترده و مشکلات اقتصادی و اجتماعی بشه.

یه سوال: چطور می تونیم با بیکاری فناورانه مقابله کنیم؟ 🤔

جواب: برای مقابله با این خطر، باید روی آموزش مهارت های جدید و مورد نیاز در عصر هوش مصنوعی تمرکز کنیم. همچنین، باید به دنبال راه هایی برای ایجاد مشاغل جدید و سازگار با تکنولوژی باشیم.

آینده بازار کار در عصر هوش مصنوعی

در آینده، بازار کار به شدت تحت تأثیر هوش مصنوعی قرار خواهد گرفت. مشاغلی که به مهارت های تکراری و قابل پیش بینی نیاز دارن، احتمالاً توسط ربات ها و سیستم های هوش مصنوعی جایگزین خواهند شد. اما در عین حال، هوش مصنوعی می تونه منجر به ایجاد مشاغل جدید در زمینه هایی مثل توسعه و نگهداری سیستم های هوش مصنوعی، تحلیل داده ها و اخلاق هوش مصنوعی بشه.

سلاح های خودمختار (Autonomous Weapons)

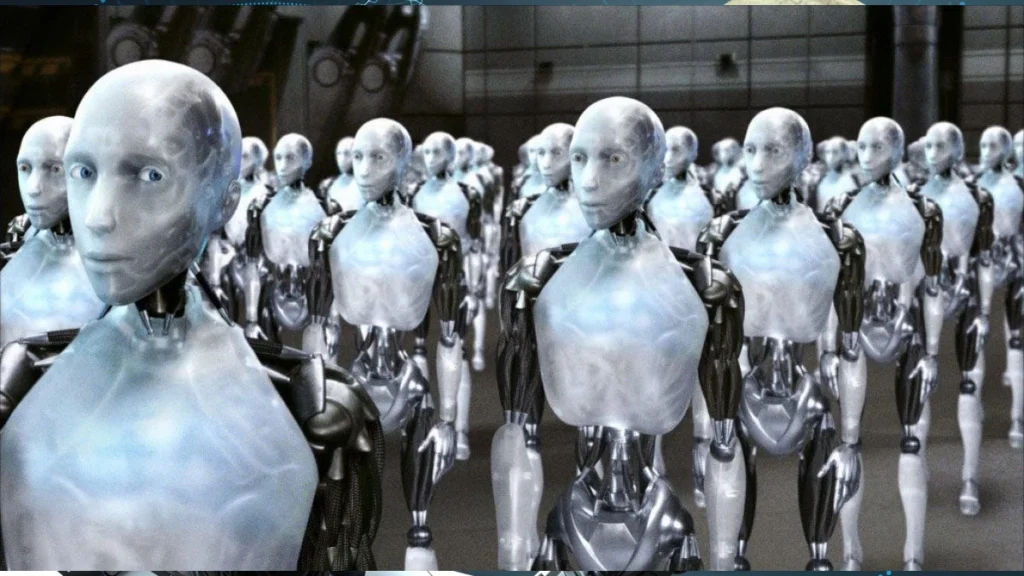

خطر ربات های قاتل

یکی از نگرانی های جدی در مورد خطرات هوش مصنوعی، توسعه سلاح های خودمختار یا “ربات های قاتل” هست. این سلاح ها می تونن بدون دخالت انسان اهداف رو انتخاب و به اون ها حمله کنن. این موضوع می تونه منجر به افزایش خشونت و کشتار در جنگ ها بشه و حتی به دست افراد و گروه های تروریستی بیفته.

یه سوال: چطور می تونیم از توسعه سلاح های خودمختار جلوگیری کنیم؟ 🤔

جواب: برای مقابله با این خطر، نیاز به همکاری بین المللی و وضع قوانین و مقررات برای محدود کردن توسعه و استفاده از سلاح های خودمختار هست.

مسئولیت اخلاقی در توسعه هوش مصنوعی

توسعه هوش مصنوعی با مسئولیت اخلاقی همراه هست. ما باید مطمئن بشیم که از این تکنولوژی برای اهداف صلح آمیز و بهبود زندگی انسان ها استفاده می شه و نه برای توسعه سلاح های مخرب.

جعل عمیق (Deepfakes)

ویدئوهای جعلی که واقعی به نظر می رسند!

یکی دیگر از خطرات هوش مصنوعی که اخیراً به شدت مورد توجه قرار گرفته، جعل عمیق یا deepfake است. جعل عمیق به ویدئوها یا صداهای جعلی گفته می شود که با استفاده از هوش مصنوعی ساخته می شوند و به طرز شگفت انگیزی واقعی به نظر می رسند.

یه سوال: جعل عمیق چه خطراتی دارد؟ 🤔

جواب: جعل عمیق می تواند برای انتشار اطلاعات نادرست، تخریب چهره افراد، و حتی ایجاد اختلاف و تنش در جامعه استفاده شود. برای مثال، ممکن است ویدئویی جعلی از یک سیاستمدار ساخته شود که در آن چیزهایی می گوید که در واقعیت نگفته است.

چگونه با جعل عمیق مقابله کنیم؟

برای مقابله با این خطر، باید از روش های تشخیص جعل عمیق استفاده کنیم. همچنین، باید آگاهی جامعه را در مورد جعل عمیق افزایش دهیم تا مردم بتوانند ویدئوها و صداهای جعلی را از واقعی تشخیص دهند.

حریم خصوصی (Privacy)

داده های ما در خطر هستند؟

یکی از خطرات هوش مصنوعی که همیشه مورد بحث بوده، نقض حریم خصوصی است. الگوریتم های هوش مصنوعی برای عملکرد بهتر به داده های زیادی نیاز دارند. جمع آوری و استفاده از این داده ها می تواند حریم خصوصی افراد را به خطر بیندازد.

یه سوال: چطور می توانیم حریم خصوصی را در عصر هوش مصنوعی حفظ کنیم؟ 🤔

جواب: برای حفظ حریم خصوصی در عصر هوش مصنوعی، باید از روش هایی مثل ناشناس سازی داده ها، رمزگذاری داده ها و یادگیری فدرال استفاده کنیم. همچنین، باید قوانین و مقررات محکمی برای حفاظت از داده های شخصی وضع کنیم.

حق فراموشی در عصر هوش مصنوعی

در عصر هوش مصنوعی، حق فراموشی اهمیت بیشتری پیدا می کند. حق فراموشی به این معنی است که افراد باید بتوانند داده های شخصی خود را از سیستم های هوش مصنوعی حذف کنند. این موضوع به خصوص در مواردی که داده ها به طور نادرست یا غیرقانونی جمع آوری شده باشند، اهمیت دارد.

تمرکز قدرت (Concentration of Power)

غول های فناوری و هوش مصنوعی

یکی از خطرات هوش مصنوعی که کمتر به آن توجه می شود، تمرکز قدرت در دست غول های فناوری است. شرکت هایی مثل گوگل، مایکروسافت و آمازون منابع و داده های عظیمی در اختیار دارند که به آن ها در توسعه و کنترل هوش مصنوعی برتری می دهد. این موضوع می تواند منجر به انحصار در بازار هوش مصنوعی و کاهش رقابت شود.

یه سوال: چطور می توانیم از تمرکز قدرت در هوش مصنوعی جلوگیری کنیم؟ 🤔

جواب: برای مقابله با این خطر، باید از رقابت در بازار هوش مصنوعی حمایت کنیم و از توسعه هوش مصنوعی متن باز (open-source) استقبال کنیم. همچنین، باید قوانین و مقررات ضد انحصار را در زمینه هوش مصنوعی تقویت کنیم.

هوش مصنوعی و نابرابری

تمرکز قدرت در هوش مصنوعی می تواند منجر به افزایش نابرابری در جامعه شود. شرکت ها و افرادی که به تکنولوژی هوش مصنوعی دسترسی دارند، می توانند از این برتری برای کسب ثروت و قدرت بیشتر استفاده کنند. این موضوع می تواند شکاف بین فقیر و غنی را بیشتر کند.

وابستگی به هوش مصنوعی (AI Dependency)

آیا ما بیش از حد به هوش مصنوعی وابسته می شویم؟

با گسترش کاربردهای هوش مصنوعی در زمینه های مختلف، ممکن است ما بیش از حد به این تکنولوژی وابسته شویم. این وابستگی می تواند منجر به کاهش خلاقیت، تفکر انتقادی و مهارت های حل مسئله در انسان ها شود.

یه سوال: چطور می توانیم از وابستگی بیش از حد به هوش مصنوعی جلوگیری کنیم؟ 🤔

جواب: برای مقابله با این خطر، باید تعادل را بین استفاده از هوش مصنوعی و توسعه توانایی های انسانی حفظ کنیم. همچنین، باید به آموزش مهارت های تفکر انتقادی و حل مسئله اهمیت بیشتری بدهیم.

هوش مصنوعی و از دست دادن کنترل

یکی از خطرات هوش مصنوعی که در فیلم های علمی تخیلی زیاد به تصویر کشیده شده، از دست دادن کنترل انسان ها بر هوش مصنوعی است. اگر هوش مصنوعی به حدی از هوش و خودآگاهی برسد که بتواند خودش را کنترل کند، ممکن است برای انسان ها خطرناک شود.

امنیت سایبری (Cybersecurity)

هوش مصنوعی و حملات سایبری

هوش مصنوعی می تواند هم برای دفاع در برابر حملات سایبری و هم برای انجام حملات سایبری استفاده شود. یکی از خطرات هوش مصنوعی این است که هکرها می توانند از الگوریتم های هوش مصنوعی برای انجام حملات سایبری پیچیده تر و مخرب تر استفاده کنند.

یه سوال: هوش مصنوعی چگونه می تواند امنیت سایبری را به خطر بیندازد؟ 🤔

جواب: هوش مصنوعی می تواند برای خودکارسازی حملات سایبری، پیدا کردن آسیب پذیری ها در سیستم ها، و حتی ساخت بدافزارهای پیشرفته تر استفاده شود. این موضوع می تواند امنیت سیستم های کامپیوتری و داده های ما را به خطر بیندازد.

هوش مصنوعی در دفاع سایبری

در عین حال، هوش مصنوعی می تواند به ما در دفاع در برابر حملات سایبری هم کمک کند. الگوریتم های هوش مصنوعی می توانند فعالیت های مشکوک را تشخیص دهند، حملات سایبری را پیش بینی کنند و به طور خودکار به آن ها پاسخ دهند.

مسائل اخلاقی و اجتماعی (Ethical and Social Concerns)

هوش مصنوعی و اخلاق

توسعه و استفاده از هوش مصنوعی با مسائل اخلاقی زیادی همراه است. برای مثال، چگونه می توانیم مطمئن شویم که هوش مصنوعی به طور عادلانه و بدون تبعیض عمل می کند؟ چگونه می توانیم از حریم خصوصی افراد در عصر هوش مصنوعی محافظت کنیم؟ چگونه می توانیم از استفاده نادرست از هوش مصنوعی جلوگیری کنیم؟

یه سوال: چه اصولی باید در توسعه و استفاده از هوش مصنوعی رعایت شود؟ 🤔

جواب: برخی از اصول اخلاقی که باید در توسعه و استفاده از هوش مصنوعی رعایت شود عبارتند از: عدالت، شفافیت، مسئولیت پذیری، حریم خصوصی و امنیت.

هوش مصنوعی و جامعه

هوش مصنوعی تأثیر عمیقی بر جامعه خواهد داشت. این تکنولوژی می تواند روش زندگی، کار و تعامل ما را تغییر دهد. برای مثال، هوش مصنوعی می تواند منجر به تغییرات در بازار کار، سیستم های آموزشی و حتی روابط اجتماعی ما شود.

خطرات هوش مصنوعی در آینده

هوش مصنوعی فوق هوشمند

یکی از خطرات هوش مصنوعی در آینده، توسعه هوش مصنوعی فوق هوشمند است. هوش مصنوعی فوق هوشمند به هوش مصنوعی گفته می شود که از هوش انسان پیشی می گیرد. اگر چنین هوش مصنوعی ای توسعه یابد، ممکن است برای انسان ها خطرناک شود.

یه سوال: آیا هوش مصنوعی فوق هوشمند یک تهدید واقعی است؟ 🤔

جواب: در حالی که توسعه هوش مصنوعی فوق هوشمند در آینده نزدیک بعید به نظر می رسد، اما این یک احتمال است که باید آن را جدی بگیریم.

کنترل هوش مصنوعی

یکی از چالش های مهم در آینده هوش مصنوعی، کنترل این تکنولوژی است. چگونه می توانیم مطمئن شویم که هوش مصنوعی همیشه در خدمت انسان ها باقی می ماند و به آن ها آسیب نمی رساند؟ این یک سوال مهم است که باید به آن پاسخ دهیم.

جدول خلاصه خطرات هوش مصنوعی

| خطر | توضیحات | راهکارها |

| تعصب در الگوریتم ها | الگوریتم های هوش مصنوعی می توانند تعصبات موجود در داده های آموزشی را یاد بگیرند و منجر به تبعیض شوند. | استفاده از داده های متنوع و بدون تعصب، بررسی و ارزیابی الگوریتم ها |

| بیکاری فناورانه | خودکارسازی وظایف با استفاده از هوش مصنوعی می تواند منجر به بیکاری گسترده شود. | آموزش مهارت های جدید، ایجاد مشاغل جدید |

| سلاح های خودمختار | سلاح های خودمختار می توانند بدون دخالت انسان به اهداف حمله کنند. | همکاری بین المللی، وضع قوانین و مقررات |

| جعل عمیق | جعل عمیق می تواند برای انتشار اطلاعات نادرست و تخریب چهره افراد استفاده شود. | روش های تشخیص جعل عمیق، افزایش آگاهی جامعه |

| حریم خصوصی | جمع آوری و استفاده از داده های شخصی می تواند حریم خصوصی افراد را به خطر بیندازد. | ناشناس سازی داده ها، رمزگذاری داده ها، یادگیری فدرال |

| تمرکز قدرت | تمرکز قدرت در دست غول های فناوری می تواند منجر به انحصار در بازار هوش مصنوعی شود. | حمایت از رقابت، توسعه هوش مصنوعی متن باز |

| وابستگی به هوش مصنوعی | وابستگی بیش از حد به هوش مصنوعی می تواند منجر به کاهش خلاقیت و تفکر انتقادی شود. | حفظ تعادل، آموزش مهارت های تفکر انتقادی |

| امنیت سایبری | هوش مصنوعی می تواند برای انجام حملات سایبری پیچیده تر استفاده شود. | استفاده از هوش مصنوعی در دفاع سایبری |

| مسائل اخلاقی و اجتماعی | توسعه و استفاده از هوش مصنوعی با مسائل اخلاقی زیادی همراه است. | رعایت اصول اخلاقی، عدالت، شفافیت، مسئولیت پذیری |

منابع مفید برای مطالعه بیشتر در مورد خطرات هوش مصنوعی

- کتاب “Superintelligence” نوشته Nick Bostrom: این کتاب به بررسی خطرات هوش مصنوعی فوق هوشمند می پردازد.

- کتاب “Weapons of Math Destruction” نوشته Cathy O’Neil: این کتاب به بررسی تعصب در الگوریتم ها و تأثیر آن بر جامعه می پردازد.

- مقاله “The Malicious Use of Artificial Intelligence” : این مقاله به بررسی خطرات استفاده نادرست از هوش مصنوعی می پردازد.

- وبسایت Future of Life Institute: این وبسایت به بررسی خطرات هوش مصنوعی و راهکارهای مقابله با آن می پردازد.

سوالات متداول در مورد خطرات هوش مصنوعی

** آیا هوش مصنوعی می تونه به بشریت آسیب برسونه؟**

بله، هوش مصنوعی در صورت استفاده نادرست یا عدم کنترل مناسب، می تونه برای بشریت خطرناک باشد.

** مهم ترین خطرات هوش مصنوعی چیست؟**

برخی از مهم ترین خطرات هوش مصنوعی عبارتند از: تعصب در الگوریتم ها، بیکاری فناورانه، سلاح های خودمختار، جعل عمیق و نقض حریم خصوصی.

** چگونه می توانیم از خطرات هوش مصنوعی جلوگیری کنیم؟**

با استفاده مسئولانه و اخلاقی از هوش مصنوعی، وضع قوانین و مقررات مناسب، و افزایش آگاهی جامعه می توانیم از خطرات هوش مصنوعی جلوگیری کنیم.

** آیا هوش مصنوعی می تونه جهان را به جای بهتری تبدیل کنه؟**

بله، هوش مصنوعی می تونه در حل بسیاری از مشکلات و چالش های جهانی مثل فقر، بیماری و تغییرات اقلیمی به ما کمک کند.

** آیا باید از هوش مصنوعی بترسیم؟**

ترس از هوش مصنوعی مفید نیست. به جای ترس، باید با آگاهی و مسئولیت پذیری از این تکنولوژی استفاده کنیم.

** نقش من به عنوان یک شهروند در مقابله با خطرات هوش مصنوعی چیست؟**

شما می توانید با افزایش آگاهی خود در مورد خطرات هوش مصنوعی، حمایت از قوانین و مقررات مناسب، و انتخاب مسئولانه در استفاده از محصولات و خدمات هوش مصنوعی، به مقابله با این خطرات کمک کنید.

** آیا شرکت شهاب به مسائل اخلاقی در هوش مصنوعی توجه می کند؟**

بله، در شرکت شهاب ما به مسائل اخلاقی در هوش مصنوعی اهمیت می دهیم و سعی می کنیم از این تکنولوژی به طور مسئولانه استفاده کنیم.

** آیا هوش مصنوعی می تونه به حفظ محیط زیست کمک کنه؟**

بله، هوش مصنوعی می تونه در زمینه هایی مثل بهینه سازی مصرف انرژی، کنترل آلودگی و حفاظت از منابع طبیعی به ما کمک کند.

** آیا هوش مصنوعی می تونه به درمان بیماری ها کمک کنه؟**

بله، هوش مصنوعی در حال حاضر در زمینه هایی مثل تشخیص بیماری ها، کشف داروهای جدید و درمان های شخصی سازی شده کاربرد دارد.

نتیجه گیری

در این مقاله، به بررسی خطرات هوش مصنوعی پرداختیم و با چالش های پیش روی این تکنولوژی قدرتمند آشنا شدیم. هوش مصنوعی مثل هر تکنولوژی دیگری، هم مزایا و هم معایب خود را دارد. با آگاهی از خطرات هوش مصنوعی و استفاده مسئولانه و اخلاقی از این تکنولوژی، می توانیم از فواید آن بهره ببریم و از معایب آن جلوگیری کنیم.

امیدواریم که این مقاله برای شما مفید بوده باشد. اگر سوال یا نظری دارید، می توانید در قسمت نظرات با ما در میان بگذارید.

شرکت شهاب، بزرگترین وبسایت در زمینه دوربین پلاک خوان و نرم افزار پلاک خوان، صمیمانه از همراهی شما تا پایان این مقاله سپاسگزار است. 🙏

شرکت شهاب از حمایت شما تا پایان این مقاله صمیمانه تشکر می کند. 😊

شرکت شهاب نرم افزار پلاک خوان | دوربین پلاک خوان | تشخیص چهره

شرکت شهاب نرم افزار پلاک خوان | دوربین پلاک خوان | تشخیص چهره

یکی از بهترین مقاله های ضد هوش مصنوعی توسط کسی نوشته شده که هم خدای برنامه نویسی هوش مصنوعیه و هم تعداد زیادی آثارش توسط هوش مصنوعی دزدیده شده! آبرو هوش مصنوعی رو با مدرک مستند کاملا برده! مقاله ش معرکه س اینجاس:

https://www.sciencesplanet.com/fa/dangers-of-ai.html